Externe Speicher

1. Hat der Computer eine ausreichend große Festplatte, so ist der Arbeitsspeicher zu klein. Hat er einen ausreichenden Arbeitsspeicher, dann ist die Festplatte zu klein.

2. Eine Festplatte mit n GB Speicherplatz ist immer zu n–1 GB voll.

3. Sind auf der Festplatte noch k GB frei, so braucht das neu zu installierende Programm mindestens k+1 GB.

(adaptiert nach: Graf, Murphys Computergesetze, Markt&Technik 1990.)

Die externen Speichermedien stellen das Gegenstück zum internen Arbeitsspeicher (RAM) dar. Während Daten im Arbeitsspeicher verloren gehen, wenn der Computer abgeschaltet ist, bleiben sie auf den externen Speichermedien erhalten.

| Arbeitsspeicher (RAM) | Externe Speicher |

| aufgebaut aus Halbleiter (RAM) | magnetische, optische Medien, aber auch Halbleiter |

| Daten und Programme nur während der Verarbeitung vorhanden | Daten und Programme können beliebig lange gespeichert werden. |

| Sehr schneller Zugriff (Nanosekunden-Bereich) | „langsamer“ Zugriff (Faktor 100.000 bis 10.000.000) |

| jedes Byte adressierbar | nur Gruppen von Byte adressierbar (Sektoren, Blöcke) |

| rein elektronisch | mit Mechanik behaftet |

Tatsächliche Speicherung von Daten auf magnetischen Speichermedien

Physikalisches Schreibverfahren

Egal ob Magnetband, Diskette oder Festplatte – das physikalische Prinzip der Speicherns und Lesens der Daten ist bei allen gleich. Kernstück ist ein drahtumwickelter Ringmagnet mit einem Spalt, der als Schreib-/Lesekopf bezeichnet wird.

Beim Beschreiben und Lesen von Festplatten sind zwei Bewegungen gekoppelt:

- die Rotation der Diskette

- die Vor-/Rückbewegung des sogenannten Schreib-/Lesekopfes

Mit Hilfe dieser Bewegungen ist die exakte Positionierung des Schreib-/Lesekopfes möglich.

Schreiben: An den Draht (physikalisch: Spule) werden Spannungsimpulse angelegt. Durch Induktion entsteht im Ringmagnet ein Magnetfeld, das durch den Spalt auf die Teilchen der Magnetbeschichtung übertragen wird. Diese Teilchen werden in einer Richtung ausgerichtet. Wird die Richtung des Schreibstroms geändert, so ändert sich auch die magnetische Flussrichtung: [genauer: auf die Weissschen Bezirke der Magnetbeschichtung. In jedem Magneten ordnen sich die Elementarmagnete in kleinen Bereichen parallel an; diese Bereiche werden in der Physik als Weisssche Bezirke bezeichnet. ]

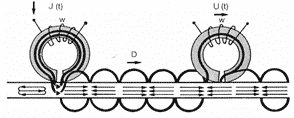

Hier sieht man das Prinzip des Schreibens (links) und Lesens (rechts). J(t) kennzeichnet den Schreibstrom, der die Magnetteilchen ausrichtet. U(t) ist die Induktionsspannung, die durch das Abtasten der magnetisch ausgerichteten Bereiche entsteht. (Copyright: BASF)

Physikalische Anmerkung: Die Aufzeichnungsdichte hängt von der Koerzitivfeldstärke ab; das ist jene Feldstärke in A/m, die notwendig ist, um die Magnetisierung an einer Stelle der magnetisierbaren Schicht vollständig zu entfernen. Je höher dieser Wert, desto sicherer sind die magnetischen Informationen gespeichert. Beispiel: Festplatten haben eine Koerzitivfeldstärke um 500 000 A/m (Angabe von Lenovo, 2018).

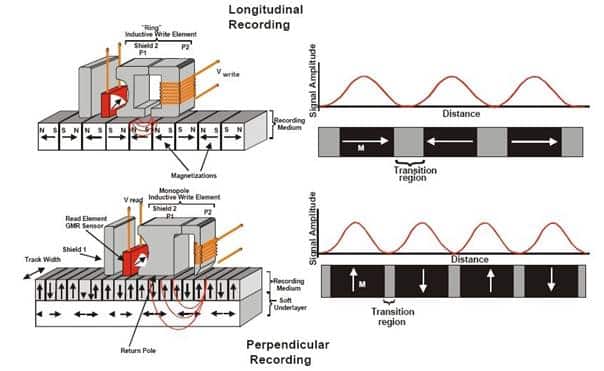

Beim aktuellen Perpendicular Recording (PR) liegen die magnetischen Momente nicht parallel zur Drehrichtung der Scheibe – das so genannte Longitudinal Recording –, sondern senkrecht dazu. Damit lässt sich zum einen die Datendichte weiter erhöhen, und zum anderen steigen auch die pro Zeiteinheit bearbeiteten Bits. Seit 2007 sind Festplatten mit über einem TByte und Datendichten von 230 GBit pro Quadratzoll erhältlich. Die vertikalen Datenbits auf dem Medium erlauben damit eine größere Datendichte, benötigen aber auch einen geringeren Abstand von Kopf und Scheibe, um die einzelnen Bits zu lokalisieren. Laut Hitachi beträgt der Abstand 10 nm für 230 GBit pro Quadratzoll.

Logisches Schreibverfahren

Vor der physikalischen Speicherung müssen die Daten kodiert werden. Dafür verwendet man Schreibverfahren:

GCR (Group Code Recording, Commodore Format)

MFM (Modified Frequency Modulation): früher gängig, wird heute nur noch für PC-Disketten verwendet.

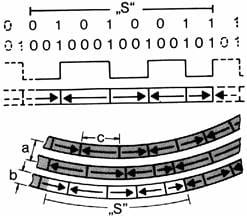

Soll beispielsweise der Buchstabe „S“ gespeichert werden, so ermittelt man zunächst den ASCII-Code für S. Dieser ist 8310 oder 0101 00112 (8 Byte). Wenn wir Disketten betrachten, so gibt es für die Aufzeichnung zwei Verfahren: FM (Frequenzmodulation) für einfache, MFM (modifizierte Frequenzmodulation) für doppelte Speicherdichte.

Bei der Frequenzmodulation werden Taktbits an den Beginn der Bitzelle geschrieben, die Datenbits D in die Mitte der Bitzelle. Bei der modifizierten Frequenzmodulation werden die Datenbits D zwar genauso in die Mitte der Bitzelle geschrieben; Taktbits werden aber nur dann an den Anfang der Bitzelle geschrieben, wenn kein Datenbit in die vorangegangene Zelle geschrieben wurde und kein Datenbit in der vorliegenden Zelle geschrieben wird.

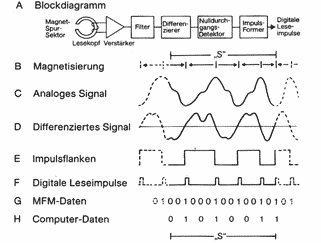

Zunächst wird der ASCII-Code des Buchstabens S MFM-codiert, diese Informationen direkt in Schreibstrom umgesetzt, woraus das Magnetisierungsmuster entsteht. Im untersten Teil der Grafik bedeuten (a) Spurabstand, (b) Spurbreite und (c) Flusswechselabstand.

Die Rückumwandlung des Magnetisierungsmusters in digitale Information (Lesevorgang) wird in der Grafik rechts oben gezeigt.

RLL (= Run Length Limited): Diese Abkürzung steht für ein Aufzeichnungsverfahren, welches eine Verbesserung des MFM-Verfahrens darstellt. Ebenfalls veralteter Festplattentyp. Datenübertragungsrate: 0,96 MB/s.

ARLL (= Advanced RLL): Weiterentwicklung von RLL, wird bei bei ESDI-, AT-BUS- und SCSI-Platten verwendet.

EFM (Eight-to-Fourteen Modulation)

PRML (Partial Response Maximum Likelihood) – heute üblich

EPRML (Enhanced PRML) – aktuellstes Verfahren

Diskette (historisch)

Unter einer Diskette (englisch „floppy disk“) verstand man eine magnetisch beschichtete Kunststoffscheibe in einem Plastikgehäuse. Das Laufwerk wird häufig mit FDD (floppy disk drive) abgekürzt.

Die Produktion von Disketten wurde 2011 endgültig eingestellt.

Aus heutiger Sicht gelten USB-Sticks und USB-Harddisks als Nachfolger der klassischen Diskette. In den 90er-Jahren entwickelte Technologien wie iomega Zip, iomega Jaz, iomega REV, Imation LS120 („Superdisk“) und HiFD (High Capacity Floppy Disk) sind heute vom Markt praktisch verschwunden.

Festplatte

Aufbau magnetischer Systeme (HDD)

Festplattenlaufwerke werden oft mit HDD (hard disk drive) abgekürzt. Vom Prinzip her arbeiten Festplatten gleich wie Disketten, jedoch haben Festplatten mehr Spuren als eine Diskette, es gibt auch mindestens zwei Schreib-/Leseköpfe. Heute werden meist mehrere Platten in einer Einheit („Plattenstapel“) verwendet. Das Plattenmaterial ist fast immer 2 mm dickes Aluminium. [Oft wird unterschieden zwischen „Fixplatten“, die in das Rechnergehäuse fix integriert sind, und „Wechselplatten“, die in einen fix mit dem Gehäuse verbundenen Wechselrahmen gesteckt werden. Da aber dieselben Produkte sowohl als „Fixplatte“ als auch als „Wechselplatte“ verwendet werden können, scheint eine Unterscheidung nicht zweckmäßig. In diesem Beitrag werden die Begriffe „Festplatte“ (weil als Datenträger starre Aluminiumplatten im Gegensatz zur Kunststoff-Folie bei Disketten verwendet werden) und „Magnetplatte“ sowohl für fix montierte als auch für austauschbare Medien verwendet. ]

Das erste Festplattenlaufwerk der Geschichte wurde 1956 von IBM ausgeliefert; es besaß einen Plattendurchmesser von 24“ und eine Speicherkapazität von 5 MB. 1973 stellte IBM ein 14“-Laufwerk mit dem Namen „Winchester“ vor, dessen Bezeichnung lange Zeit synonym zum Begriff „Magnetplatte“ verwendet wurde.

Beispiele für führende Festplattenhersteller sind Seagate, Western Digital, Hitachi GST, Samsung und Toshiba/Fujitsu.

Zum Vergleich: Das menschliche Gehirn fasst bei einem mittleren Gewicht von 1,5 kg bei rund 30 Milliarden Nervenzellen über 4 Terabyte an Daten.

Heute sind nur mehr Baugrößen 2,5“ und 3,5“ üblich.

| Formfaktor | Breite | Höhe | Größte verfügbare Kapazität | Maximale Anzahl von Platten |

| 3,5“ | 102 mm | 25,4 mm | 18 TB (2020) | 9 |

| 2,5“ | 69.9 mm | 7–15 mm | 5 TB (2017) | 5 |

Der Festplattenhersteller Seagate hat 2021 angekündigt, bis 2026 Festplatten mit 50 TB Speicherkapazität auf den Markt zu bringen, etwa 2030 soll dann die 100 TB-Grenze durchbrochen werden. Diese Kapazitäten sollen einerseits durch Steigerung der Speicherdichte, andererseits durch Verwendung mehrerer Platten und 2 unabhängig zu steuernden Gruppen von Schreib-Lese-Köpfen möglich werden.

die jeweils mit einem eigenen Aktuator gesteuert werden

(Quelle: https://www.seagate.com/gb/en/innovation/multi-actuator-hard-drives/)

Bei Festplatten ist die magnetisierte Schicht viel dünner als bei einer Diskette. Man kann daher den Schreib-/Lesekopf (der genauso aufgebaut ist wie der von Diskettenlaufwerken) nicht mehr direkt auf die Schicht aufsetzen lassen, da diese innerhalb kürzester Zeit abgerieben wäre. Die Lösung: Die Magnetplatte rotiert sehr schnell (5400 – 12000 Umdrehungen pro Minute; das entspricht einer Geschwindigkeit von mehr als 60 km/h bei 3½“-Festplatten und sogar mehr als 90 km/h bei älteren 5¼“-Laufwerken!), dadurch entsteht „Fahrtwind“, der den leichten Schreib-/Lesekopf mühelos trägt (Abstand zur Oberfläche: 0,2 Mikrometer). Vorteil: Der Kopf kann sich an die Plattenoberfläche anpassen.

Hier sind Staubkörner usw. natürlich noch fataler als bei Disketten: Stößt der Schreib-/Lesekopf auf so einen Riesenbrocken, so wird er in die Höhe geschleudert und fällt nach dem Hindernis auf die Platte („head crash“). Dieses Aufschlagen beschädigt die Magnetschicht und damit die Daten. Um vor Luftverunreinigungen und Staubkörnern sicher zu sein, ist das Gehäuse heute meist mit Edelgas gefüllt und steht unter leichtem Druck. Undichtheiten führen daher zu einem langsamen Ausströmen des Gases. (Die frühere Methode, das Gehäuse zu evakuieren, führte bei undichten Stellen dazu, dass Außenluft angesaugt wurde!) Gleichermaßen gefährlich sind aber mechanische Einwirkungen von außen (Stöße, Umstellen des Geräts).

Beim Abschalten des Geräts wird der Kopf in die so genannte „Landing Zone“ gebracht, in der keine Daten gespeichert sind. Diese Zone befindet sich normalerweise ganz außen auf der Platte; dort setzt der Kopf auf. (Bei älteren Geräten musste man ein „Park-Programm“ ablaufen lassen.)

Ein Festplattenlaufwerk besteht fast immer aus mehreren Festplatten, die zu einem Stapel zusammengefasst werden.

Die Bewegung der Platten und des Schreib-Lese-Kamms erfolgte früher durch langsame Schrittmotoren (diese werden heute noch in Diskettenlaufwerken verwendet); nach jeder Bewegung mussten die Schreib-/Leseköpfe erst ausschwingen, bevor mit dem Schreib- bzw. Lesevorgang begonnen werden konnte. Diese und auch andere Probleme hat man heute durch Verwendung von Servomotoren und Aufzeichnung von Spurinformationen weitgehend im Griff.

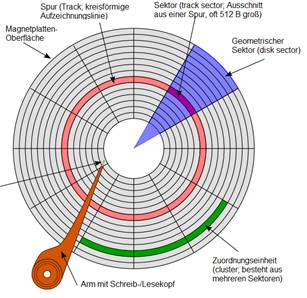

Bei der sogenannten Low-Level-Formatierung der Festplatte werden die Zylinder und Sektoren der Platte definiert:

Die einzelnen Festplatten sind in Spuren und Sektoren unterteilt (genauso wie Disketten). Pro Inch können z.B. bis zu 1500 Spuren angelegt werden. Alle untereinanderliegenden Spuren bilden einen Zylinder, der mit einer Zylinderadresse versehen ist.

Auch bei Festplatten ist die kleinste ansprechbare Einheit nicht 1 Byte, sondern mindestens der Inhalt eines Sektors pro Spur (128 Byte bis 4 KB). DOS etwa fasst beim Formatieren aus Verwaltungsgründen meist 4 oder 8 Sektoren zu einem Cluster (Block) zusammen. Die kleinste Zuordnungseinheit beträgt daher 512 bzw. 1024 Byte.

Hier gibt es Schreib-Lese-Köpfe für jede magnetisierbare Schicht einer Platte (Ausnahme: oberste und unterste Schicht).

Jede Spur ist mit einer Spuradresse versehen. Die Daten werden bitseriell gespeichert und zu einem Block zusammengefasst, der seinerseits mit einer Blockadresse versehen wird (bitseriell = Bits hintereinander).

Gütekriterien

- Transferrate (in KB/s oder MB/s) = Datenmenge, die in einer Sekunde an die CPU geleitet werden kann; unter 5 MB/s sollte man sich bei einer Platte mittlerer Größe nicht zufrieden geben.

- Integrierter Festplatten-Cache (= eigener Speicher, der die gelesenen Daten einer Spur speichert und weitergibt), der auch „vorauslesen“ kann, d.h. während die Daten einer Spur weitergegeben werden, werden schon die der nächsten Spur ausgelesen.

- Mittlere Zugriffszeit (in ms) = Zeit, die die Festplatte durchschnittlich zum Finden und Laden eines Datensatzes benötigt; sollte unter 10 ms liegen.

- Die mittlere Zugriffszeit einer Festplatte setzt sich aus zwei Zeiten zusammen:

- (a) der Zeit, die der Schreib-/Lesekopf benötigt, um die richtige Spur zu finden (Positionierungszeit)

- (b) der Zeit, die die Festplatte benötigt, um den richtigen Sektor durch Rotation um die eigene Achse einzustellen (Latenzzeit)

- Step-Rate = Positioniergeschwindigkeit der Schreib-/Leseköpfe

- Umdrehungszahl: 5400 – 15000 min-1

- Aufzeichnungsdichte (tpi, tracks per inch)

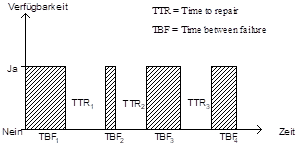

- MTBF = mean time between failure: Die beste Festplatte wird einmal kaputt. Bei der Entwicklung eines Plattentyps testet die Herstellerfirma, wie lang durchschnittlich eine Festplatte störungsfrei läuft:

- Die „mean time between failure“ = MTBF (= mittlere Zeit zwischen zwei Ausfällen) ergibt sich durch

- Die Anzahl der Ausfälle eines Systems ergibt normalerweise folgende Kurve:

Das bedeutet: Bei Festplatten kann es vorkommen, dass sie gleich zu Beginn nicht funktionieren (z.B. durch Produktionsfehler); falls aber die Anfangsschwierigkeiten überwunden sind, laufen sie normalerweise störungsfrei bis zur MTBF. Diese beträgt um die 100 000 Stunden (1 Jahr = 8700 Stunden, also mehr als 11 Jahre).

Für die Verwaltung einer Festplatte benötigt der Computer einen „Controller“.

Solid State Drive (SSD)

Ein Solid State Drive, kurz „SSD“ (zu deutsch: allgemein „Festkörperlaufwerk“ oder speziell auch „Halbleiterlaufwerk“) ist ein Speichermedium, das wie eine herkömmliche magnetische Festplatte eingebaut und angesprochen werden kann, ohne eine rotierende Scheibe oder andere bewegliche Teile zu enthalten, da nur Halbleiterspeicherbausteine verwendet werden. Vorteile eines Solid State Drive sind mechanische Robustheit, kurze Zugriffszeiten, niedriger Energieverbrauch und das Fehlen jeglicher Geräuschentwicklung.

Der Hauptnachteil ist ein erheblich höherer Preis im Vergleich zu Festplatten gleicher Kapazität. Daher haben SSDs für Endanwender – um den Preis im Rahmen zu halten – meist kleinere Kapazitäten wie herkömmliche Festplatten

Daten 2017

- bis zu 50 TB; häufig 0,5 – 2 TB

- Kosten zwischen € 0,30 und € 0,80 pro GB

- Lebensdauer 1,5 – 2,0 Mio. Stunden

- Schnittstellen: PCIe (Schreibgeschwindigkeit bis 900 MB/s) oder häufiger SATA (520 MB/s)

Schnittstellen für Festplatten

Bei den Schnittstellen für Festplatten ist seit einigen Jahren ein Umdenken zu beobachten: Viele Jahre lang waren parallele Schnittstellen in Verwendung; neue Festplattensysteme verwenden durch die Bank serielle Schnittstellen:

Parallele Schnittstelle

- IDE/ATA (1986)

- EIDE/UATA (1994)

- SCSI

Serielle Schnittstelle

- SATA (2002)

- SATA II (2005)

- SATA III (2008/09)

- SATA Express (2013)

- SAS-3 (2013)

- SAS-4 (2017)

IDE/ATA (1986): Die Bezeichnung IDE (Integrated Devices Equipment, Integrated Disk Environment) kommt von der Tatsache, dass der eigentliche Controller direkt auf dem Festplattenlaufwerk integriert ist. ATA bedeutet „Advanced Technology Attachment“ und bezieht sich auf die bei der Einführung des Standards übliche Kommunikation mit dem ISA-Bus. Die Begriffe IDE und ATA bezeichnen nicht dasselbe: IDE definiert den Anschluss der Laufwerke, wie Pinbelegung, Stecker, Kabel und elektrische Signale. ATA definiert das Protokoll, mit dem die Daten über die Leitungen (IDE) transportiert werden.

Ursprünglich hatten IDE-Platten eine Maximalgröße von 528 MB.

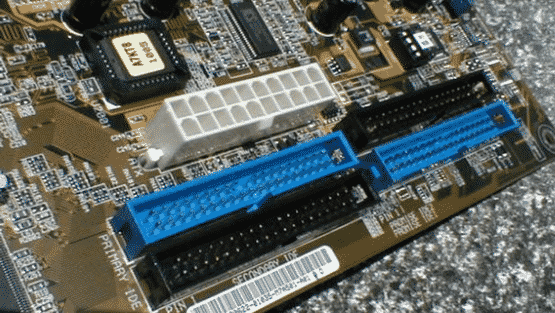

ATA-Platten sind durch ein 40poliges Flachbandkabel mit der AT-Bus-Controllerplatine, die sich auf dem Motherboard befindet, verbunden.

Der AT-Bus-Controller besitzt eine Funktion zur automatischen Fehlerkorrektur. Das bedeutet: Tritt bei der Benutzung der Festplatte nach einer gewissen Zeit ein Fehler in einem bestimmten Bereich (Sektor) auf, so versucht der IDE-Controller, die Daten zu rekonstruieren. In etwa 95 % aller Fälle gelingt ihm dies; die Daten werden auf einen anderen Sektor geschrieben. In jedem Fall wird der beschädigte Bereich als fehlerhaft deklariert, sodass auf ihn nicht mehr zugegriffen werden kann. Die ursprüngliche Datenübertragungsrate betrug 800 KByte/s.

Mit diesem Controller sind üblicherweise zwei, maximal vier Festplatten ansprechbar (die primäre Festplatte erhält den Namen C:, die anderen heißen D: usw.). Die Festplatten müssen im BIOS-Setup eingetragen werden.

Enhanced IDE (EIDE), Ultra ATA (1994): wird eine abwärtskompatible Verbesserung der IDE-Norm bezeichnet. Hier sind Datenübertragungsraten bis zu 20 MB/s möglich.

Die EIDE-Schnittstelle (Enhanced Intelligent/Integrated Drive Electronics) ist eine Weiterentwicklung des IDE-Standards. EIDE unterstützt bis zu 4 Laufwerke und ermöglicht den Anschluss von Festplatten, CD-ROM, CD-Brenner, DVD, Streamer und andere Wechselspeicherträger (ATAPI).

www.planet3dnow.de

Im Laufe der Zeit, seit es EIDE/ATA gibt, haben sich die Festplatten-Hersteller auf verschiedene Betriebsarten geeinigt. Dadurch wurde es möglich ältere Festplatten parallel zu neueren zu betreiben. Das hatte jedoch den Nachteil, dass die schnellere Festplatte sich der langsameren in ihrer Geschwindigkeit anpassen musste.

Für den Datentransfer gibt es zwei Protokolle. Den älteren PIO-Modus (Programmed Input/Output) und den neueren UDMA-Modus (Ultra Direct Memory Access). Beim PIO-Modus ist der Prozessor für jeden Lese- und Schreibvorgang verantwortlich. Der UDMA-Modus kann über den DMA-Controller direkt auf den Arbeitsspeicher zugreifen. So kann der Prozessor sich um andere Aufgaben kümmern. Das gesamte System läuft schneller.

Übertragungsrate

MByte/s Modus

3,33 IDE (ATA) PIO 0

5,22 IDE (ATA) PIO 1

8,33 IDE (ATA) PIO 2

4,16 IDE Multiword-DMA 0

13,33 IDE Multiword-DMA 1

16,66 IDE Multiword-DMA 2

11,11 EIDE (Fast ATA-2) PIO 3

16,66 EIDE (Fast ATA-2) PIO 4

Der Ultra-DMA-Modus (Ultra-ATA) unterstützt höhere Datenübertragungsraten und besitzt eingebaute Sicherheitsmechanismen. Zusätzlich wird die Belastung des Prozessors bei der Datenübertragung durch einen Bus-Master-Treiber reduziert. Dieser Treiber muss aktiviert werden. Bei Geräten, die damit nicht umgehen können muss er deaktiviert werden. Das Bus-Mastering ist ein Datentransfer-Verfahren für die Übertragung von Daten und Befehlen, bei dem der Host-Controller direkt auf dem Arbeitsspeicher zugreift, ohne den Prozessor zu belasten.

Für alle Ultra-ATA-Festplatten (133/100/66) wird ein UDMA-Kabel benötigt. Dieses Flachbandkabel hat 80 Leitungen, 40 für den Datenverkehr und 40 für die Erdung.

Der Ultra-DMA-Standard 133 ist abwärtskompatibel. An diesen Controllern lassen sich auch andere Ultra-ATA-Festplatten (66 und 100) betreiben.

Übertragungsrate

MByte/s Modus

16,66 Ultra-DMA/0 (ATA/16)

25,0 Ultra-DMA/1 (ATA/25)

33,33 Ultra-DMA/2 (ATA/33)

44,4 Ultra-DMA/3 (ATA/44)

66,66 Ultra-DMA/4 (Ultra-ATA/66)

99,99 (100) Ultra-DMA/5 (Ultra-ATA/100)

133 Ultra-DMA/6 (Ultra-ATA/133)

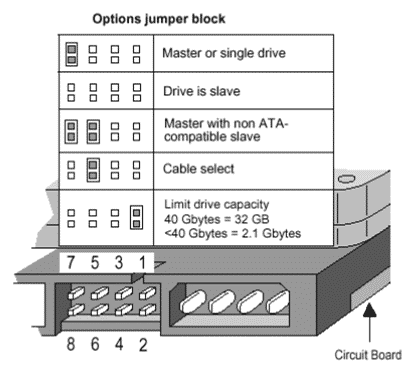

Werden zwei Geräte an einem Kanal betrieben, so müssen diese eigens „gejumpert“ werden. Dies dient lediglich zum korrekten Ansprechen der Komponenten. Der Jumper befindet sich neben dem Stromanschluss am Gerät, es gibt mehrere Konfigurationsmöglichkeiten:

Die Kabellänge für einen an der ATA-Schnittstelle angeschlossenen Massenspeicher ist auf 46 cm begrenzt.

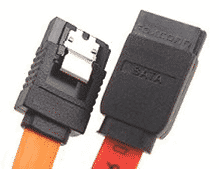

SATA I (SATA-150; 2002): Schnittstellen für Massenspeicher waren bisher immer in paralleler Ausführung realisiert. Mit zunehmender Übertragungsgeschwindigkeit ergeben sich technische Schwierigkeiten, die für die Übertragungsrate eine obere Grenze setzt. So bleibt auch die ATA (EIDE)-Schnittstelle nicht davon verschont, dass sie auf den seriellen Betrieb umgestellt wird.

Im Jahr 2000 setzten sich mehrere Firmen aus dem IT-Sektor zusammen, um eine Spezifikation über Serial ATA (Serielles ATA) zu erstellen. Im Jahr 2001 wurde die erste Version von Serial ATA vorgestellt. Anfang 2003 waren bereits die ersten Controller und Festplatten erhältlich. Bis zur vollständigen Marktdurchdringung hat es noch bis zum Jahr 2004 gedauert.

Mit 150 MByte/s hat S-ATA direkt an die parallele ATA-Schnittstelle (P-ATA) mit 133 MByte/s angeknüpft. Die Serial-ATA-Schnittstelle unterstützt 1,5 GBit/s bei einer Nettodatenrate von ca. 150 MByte/s. Festplatten mit 10.000 Umdrehungen in der Minute (U/m) liefern rund 75 MByte/s an Daten. Die Schnittstellengeschwindigkeit reicht also auch für die Zukunft locker aus.

Die parallele Datenübertragung erreicht ihre hohe Übertragungsgeschwindigkeit nur über sehr kurze Strecken. Je länger ein Kabel ist, desto eher treten Laufzeitdifferenzen zwischen den parallelen Signalen auf. Dies kann nur durch eine kürzere Übertragungsstrecke oder eine geringere Taktrate verhindert werden. Zusätzliche Masseleitungen führen zu dicken und unflexiblen Flachband- oder Rundkabeln, die die Luftströmung innerhalb eines Computers verhindert.

Um die Kompatibilität zu gewährleisten, werden die parallel vorliegenden Daten mit Wandlern in serielle Datenströme konvertiert. Die hohe Integrationsdichte und die extrem schnelle interne Verarbeitungsgeschwindigkeit in integrierten Schaltungen erlauben die Wandlung in nahezu Echtzeit. Die Wandlung von parallel nach seriell bzw. umgekehrt erhöht die Komplexität und die Kosten auf der Hardware-Seite. Dafür lässt sich mit niedrigeren Spannungen arbeiten, das wiederum bei Kabeln mit 1 Meter Länge schnellere Schaltzeiten und geringere EMV-Probleme ermöglicht.

www.seagate.com

Für den Anschluss von SATA-Geräten wird ein dünnes Kabel mit einem kleinen Stecker verwendet.

SATA II (SATA-300; 2005): SATA II ist eine Erweiterung von SATA der Version 1. SATA-II-Festplatten lassen sich auch an der SATA-Schnittstelle der Vorgängerversion anschließen. Sie laufen dann mit einer geringeren Schnittstellengeschwindigkeit und verzichten auf moderne Festplatten-Features. Unabhängig von der Geschwindigkeit dürfen auch die gleichen Kabel verwendet werden.

SATA-II-konforme Kabel unterscheiden sich von den einfachen S-ATA-Kabeln nur durch den Schnappverschluss am Stecker. Die Verbindung zwischen Laufwerk und Motherboard ist dann deutlich fester. Locker sitzende Kabel gibt es dann nicht mehr.

Die Serial-ATA-II-Spezifikation bringt das Native Command Queuing (NCQ), was unter dem Namen Tagged Command Queuing im SCSI-Bereich bereits seit vielen Jahren bekannt ist. NCQ erlaubt dem Festplatten-Controller das Puffern von Lese-Befehlen und die Reihenfolge der Abarbeitung eigenständig zu regeln. So soll durch die Umsortierung die Lese-Kopf-Bewegungen optimiert und dadurch die Zugriffszeit verkürzt werden.

Serial-ATA-II unterstützt theoretisch 3 GBit/s, bei einer Nettodatenrate von 300 MByte/s. Weil Festplatten auch in Zukunft die Daten nicht so schnell speichern und lesen können, ist die Schnittstelle bei vielen Festplatten nur für 1,5 GBit/s ausgelegt.

In der SATA-II-Spezifikation ist eine Funktion mit dem Namen Port-Multiplier definiert. Über diesen Mechanismus kann der Punkt-zu-Punkt-Datenstrom auf mehrere Geräte aufgeteilt werden. Port-Multiplier funktioniert ähnlich wie USB. Bis zu 15 Geräte lassen sich an einem SATA-II-Port betreiben. Bei 4 Geräten mit ca. 70 MByte/s würden 3 Gbit/s ausreichen, um alle Geräte ohne Geschwindigkeitsverlust bedienen zu können.

SATA III (SATA-600; 2008/09): Spezifikation SATA 3.0; theoretische Datenrate 6 Gbit/s bzw. Netto-Geschwindigkeit 600 Mbyte/s.

SATA-Express (SATAe; 2013): Spezifikation SATA 3.2; theoretische Datenraten 8 bzw. 16 Gbit/s, Netto-Geschwindigkeit 985 bzw. 1969 Mbyte/s.

SCSI-Host-Adapter (= Small Computer Systems Interface): parallele 8-bit-Schnittstelle in Form einer Steckkarte. Beim SCSI-Verfahren wird ein eigenes intelligentes Bussystem verwendet, während das AT-Bus-System – wie der Name schon sagt – den AT-BUS (ISA) nutzt. Dieser Controller eignet sich nicht nur für die Verwaltung von Festplatten, sondern für max. 7 beliebige Einheiten (z.B. MOs, WORMs, Streamer, CD-ROM-Laufwerke etc.); „selbstkorrigierende“ Festplatten. Datenübertragungsrate: bis 320 MB/s. Die Festplatten müssen nicht im CMOS-Setup eingetragen werden! Die eigentliche Steuerelektronik befindet sich auf dem Laufwerk, während die Host-Adapter-Karte nur die Verbindung zwischen den Laufwerken herstellt.

ATA-Platten und SCSI-Platten können nebeneinander in einen Rechner eingebaut werden.

Während ATA-Platten in das CMOS-Setup eingetragen werden müssen, ist dies bei SCSI-Platten nicht erforderlich. Diese benötigen stattdessen aber eigene Treiber, die RAM-Speicher verbrauchen.

Während ATA-Platten teilweise durch die CPU gesteuert werden, haben SCSI-Festplatten den Controller am Adapter. Die CPU wird damit entlastet. Das ist besonders bei der Verwaltung großer Datenmengen eine Entlastung für die CPU; sie kann sich während einer Festplattenoperation um andere Aufgaben kümmern.

SAS (Serial Attached SCSI): trat 2004 die Nachfolge der bisherigen parallelen SCSI-Schnittstelle an. Auf der Bitübertragungsschicht arbeitet SAS seriell mit einer Übertragungsrate von 3 Gbit/s (SAS-1, 2004), 6 Gbit/s (SAS-2, 2009), 12 Gbit/s (SAS-3, 2013) bzw. 22,5 Gbit/s (SAS-4, 2017).

RAID

Bereits seit Jahrzehnten war Datensicherheit sowie Zugriffsgeschwindigkeit im Zusammenhang mit der Verwendung von Festplatten die beiden wichtigsten Themen.

Um nun den Datenzugriff auf Massenspeicher zu beschleunigen und die Datensicherheit zu erhöhen, entwickelten 1987 die Professoren Gibson, Katz und Patterson der Berkeley University den RAID-Standard Die Abkürzung bedeutet Redundant Array of Inexpensive/Independent Disks.

Der Begriff Redundanz kommt aus dem Lateinischen (redundantia = Überfluss, Überfülle) und bezieht sich in der Informationstechnologie auf mehrfach gespeicherte (also eigentlich überflüssige) Daten, die aber verwendet werden können, um im Fehlerfall Datenverlust zu vermeiden.

Man unterscheidet verschiedene „RAID-Levels“, die entweder Leistung oder Datensicherheit oder beides ermöglichen.

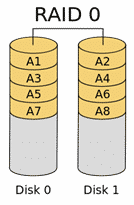

RAID Level 0 (Striping)

Streng genommen keine echte RAID-Implementierung. Bei der Datenspeicherung werden die Daten in „Streifen“ zerteilt, diese Datenstücke werden auf mindestens zwei Platten aufgeteilt.

Zweck: schnellerer Datendurchsatz

Verfügbare Speicherkapazität: 100 %

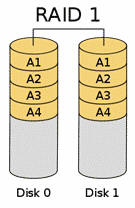

RAID Level 1 (Mirroring, dt. Spiegelung)

Die Daten werden gleichzeitig auf zwei Platten gespeichert. Fällt eine Platte aus, so sind die Daten auf der anderen Platte identisch verfügbar.

Verfügbare Speicherkapazität: 50 %

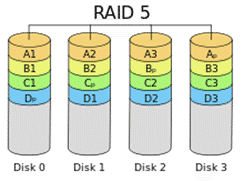

RAID Level 5 (Block Striping with Parity)

Möglich sind RAID 5-Arrays mit mindestens drei, Platten. Die beste Leistung bieten Systeme mit 3, 5 oder 9 Platten.

Die Daten werden (so wie bei RAID 0) in Blöcke zerteilt, zusätzlich werden aber Paritätsinformationen auf alle Platten verteilt geschrieben.

RAID 5 bietet Performancesteigerung bei gleichzeitiger Erhöhung der Betriebssicherheit (eine Platte des RAID 5-Arrays darf ausfallen).

Verfügbare Speicherkapazität

| Laufwerke | Belegter Speicherplatz | Verfügbarer Speicherplatz | Redundanz |

| 3 | 6 GB | 4 GB = 67 % | 33 % |

| 4 | 8 GB | 6 GB = 75 % | 25 % |

| 5 | 10 GB | 8 GB = 80 % | 20 % |

Hintergrund – Funktionsweise der Paritätsprüfung

Das Paritätsprüfungsverfahren ist bereits seit vielen Jahren bekannt und ermöglicht die Erkennung und Behebung von Fehlern. Technisch betrachtet, werden die Daten der Nutzlaufwerke über eine logische Exklusiv-Oder-Operation (XOR) verknüpft, das Ergebnis dieser Verknüpfung wird als Paritätsinformation bezeichnet und auf einem eigenen Parity-Laufwerk gespeichert.

Das Ergebnis der Verknüpfung ist dann 1, wenn eine ungerade Anzahl von Bitstellen eine 1 aufweist. Bei einer geraden Anzahl dagegen ist das Ergebnis 0.

Beispiel

| Disk 0 | Disk 1 | Disk 2 | Disk 3 Parität |

| 0 | 1 | 1 | 0 |

| 1 | 0 | 0 | 1 |

In der ersten Zeile sieht man, dass zwei Bitstellen 1 sind, also eine gerade Anzahl – daher wird als Paritätsinformation eine 0 gespeichert. In der zweiten Zeile sieht man, dass nur eine Bitstelle 1 ist, eine ungerade Anzahl – daher wird als Parität der Wert 1 gespeichert.

Hinweis: Nur in diesem Beispiel wird die Parität auf Disk 3 gespeichert – wie auf der Grafik ersichtlich ist, werden die Paritätsinformationen auf allen Platten verteilt.

Die Rekonstruktion kann durch eine weitere XOR-Verknüpfung erfolgen.

Beispiel

| Disk 0 | Disk 1 | Disk 2 | Disk 3 Parität |

| 0 | defekt | 1 | 0 |

| 1 | defekt | 0 | 1 |

Nehmen wir an, dass Disk 1 defekt ist – die fehlenden Informationen müssen also wiederhergestellt werden.

Auf Disk 0 ist eine binäre 0 gespeichert, auf Disk 2 eine binäre 1 – also eine ungerade Anzahl von 1-Werten. Wenn also auf Disk 1 eine 0 gespeichert wäre, so müsste die Parität 1 sein; da die Parität aber 0 ist, ergibt sich somit für den fehlenden Wert auf Disk 1 der Wert 1. Analog lässt sich für die zweite Zeile ableiten, dass eine binäre 0 fehlt.

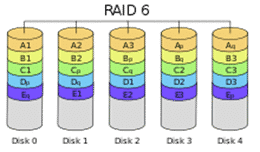

RAID Level 6 (Striping with double Parity)

Ähnliches Konzept wie RAID 5, allerdings werden doppelte Paritätsinformationen verteilt gespeichert, sodass der Ausfall von zwei Platten toleriert wird. Die minimale Anzahl von Platten beträgt 4.

RAID 10

Unter RAID 10 (genauer: RAID 1+0) versteht man die Kombination von RAID 0 und RAID 1, also ein RAID 0-Array aus zwei Platten, das mit RAID 1-Technologie gespiegelt wird. Dafür sind mindestens 4 Festplatten notwendig.

RAID-Systeme können hardwaretechnisch oder softwaretechnisch realisiert werden.

Hardware-RAID: Hier wird das Zusammenarbeiten mehrerer Festplatten durch einen RAID-Controller organisiert. Solche Controller befinden sich meist in physischer Nähe der verwalteten Festplatten, entweder im Computergehäuse selbst oder als Teil eines Storage-Systems. Hardware-RAID-Systeme sind im Server-Bereich üblich. Moderne RAID-Systeme verfügen über zusätzliche Sicherheits- und Überwachungsmechanismen, wie etwa die Möglichkeit des „Hot Mounting“

(Austausch im laufenden Betrieb) und der laufenden Überprüfung des Zustandes der Festplatten. Ein weiteres Merkmal von modernen RAID-Systemen ist die Integration von eigenem Cache-Speicher, der die Leistungsfähigkeit stark erhöhen kann.

Software-RAID: Die Organisation der Festplatten wird in diesem Fall vom Betriebssystem übernommen. Windows Server-Betriebssysteme bieten seit der Version Windows Server 2000 eine Software-RAID-Implementierung an. Die Festplatten werden zunächst ohne RAID-Controller als sogenannte JBODs („just a bunch of disks“) ins System integriert, dann wird per Software-RAID die RAID-Funktionalität realisiert.

Für welche Variante man sich entscheidet, wird von Kosten-Nutzen-Überlegungen abhängen. Folgende Fragen sollten gestellt werden:

- Wie wichtig – d.h. sicherheitsrelevant – sind Daten?

- Wie oft muss auf die Daten zugegriffen werden?

- Handelt es sich um wenige große oder viele kleine Dateien?

Beachten Sie: In keinem Fall stellen RAID-Systeme einen Ersatz für ein regelmäßiges Backup dar!

Storage-Technologien

Online-Storage wird üblicherweise in zwei Kategorien eingeteilt:

- File Access (Dateizugriff): Typische Office-Anwendungen verwalten Daten üblicherweise als Dateien (*.doc, *.docx, *.mp3, *.pdf, *.gif usw.).

- Block Access (Blockzugriff): Datenbanken, Hypervisor-Programme und E-Mail-Applikationen greifen auf ihre Daten ohne den Overhead eines Dateisystems zu. Sie greifen auf die Daten direkt zu, wobei immer Datenblöcke adressiert werden können.

Im Business-Bereich müssen Lösungen gefunden werden, um riesige Datenmengen rasch und ausfallssicher allen Clients zur Verfügung zu stellen. Hier gibt es folgende Ansätze:

Direct Attached Storage (DAS)

Direct Attached Storage (DAS) oder Server Attached Storage bezeichnet an einen einzelnen Host angeschlossene Festplatten, die sich in einem separaten Gehäuse befinden.

Die übliche Schnittstelle ist SCSI und zunehmend SAS. Möglich sind jedoch sämtliche blockorientierten Übertragungsprotokolle, beispielsweise ATA/ATAPI, Fibre Channel, iSCSI oder FICON/ESCON. Die Festplatten bieten damit die gleiche Leistung wie im Host verbaute.

Im Unterschied zu Network Direct Attached Storage, Network Attached Storage oder einem Storage Area Network können andere Computer die Festplatten nur über den Host nutzen, an den sie angeschlossen sind.

Shared DAS: Inzwischen gibt es auch DAS-Geräte, die von mehreren Servern gemeinsam benutzt werden können.

Network Attached Storage (NAS)

Network Attached Storage (NAS) bezeichnet einfach zu verwaltende Dateiserver. Allgemein wird NAS eingesetzt, um ohne hohen Aufwand unabhängige Speicherkapazität in einem Rechnernetz bereitzustellen.

Ein NAS ist im Unterschied zu Direct Attached Storage ein eigenständiger Host mit eigenem Betriebssystem. Da die Funktionen sehr spezifisch auf den Einsatzzweck abgestimmt sind, werden Fehler aufgrund umfangreicher und für den speziellen Einsatzzweck unnötiger Konfigurationsmöglichkeiten von vorneherein vermieden. Dateibasierende Dienste wie NFS oder SMB/CIFS stellen die Kernfunktion dar. Eine handelsübliche Festplatte, die sich in einem externen Gehäuse befindet, das mit einer „RJ-45“-Netzwerkbuchse, entsprechender Firmware und optional weiteren Anschlussmöglichkeiten ausgestattet ist, entspricht bereits einem NAS.

Eine Einschränkung für NAS stellt seine Verbindung zu anderen Computern über Ethernet dar. Dessen geringe Rahmengrößen und großer Protokoll-Overhead ist nicht für den schnellen Zugriff auf Massenspeicher ausgelegt. Als Massenspeicher für andere Server bietet NAS deshalb wenig Leistung und belastet das vorhandene Netz zusätzlich. Ein Storage Area Network vermeidet diese Nachteile.

Dabei handelt es sich um einen „normalen“ Server mit einem speziellen für Storage-Zwecke angepassten Betriebssystem, etwa Microsoft Storage Server 2008 oder ein angepassten Linux.

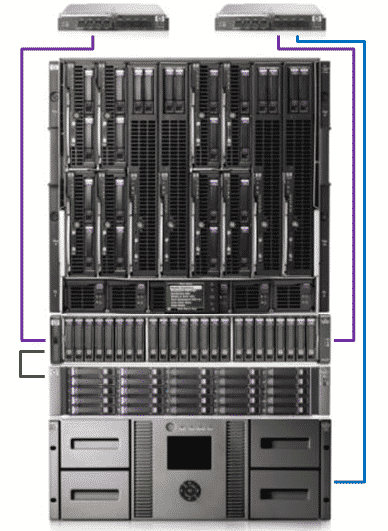

Storage Area Network (SAN)

Als Storage Area Network (SAN, dt. Speichernetzwerk) bezeichnet man im Bereich der Datenverarbeitung ein Netzwerk zur Anbindung von Festplattensubsystemen und Tape-Libraries an Server-Systeme.

In den meisten SANs wird das SCSI-Kommunikationsprotokoll verwendet, das auf Fibre Channel (FC) oder iSCSI als Transport-Protokoll aufsetzt.

Ein Storage Area Network (SAN) ist eine Erweiterung von Direct Attached Storage (DAS). Während DAS eine Punkt-zu-Punkt-Verbindung zwischen einem Server und einem Daten-Speicher bildet, ermöglicht ein SAN die Anbindung mehrerer Server an mehrere Speicher-Systeme über ein Netzwerk.

HP MSA StorageWorks 2000i G2 (MSA = Modular Smart Array);

das i bezeichnet die iSCSI-Unterstützung – Quelle: HP

Cisco MDS 9216i

Ein großer Vorteil des SAN ist die Virtualisierung der vorhandenen Plattensubsysteme. Der verteilt vorhandene Massenspeicher kann virtuell wie eine einzige Festplatte behandelt werden. Den einzelnen Server-Systemen werden dann auf dieser virtuellen Festplatte Partitionen zugewiesen, die diese Server über die Host Bus Adapter wie eine eigene Festplatte einbinden können. Der vorhandene Speicherplatz kann so viel effektiver genutzt und zentral verwaltet werden, da es jederzeit im laufenden Betrieb möglich ist, die Größe des zugewiesenen Speicherbereichs für die Server im Storage Area Network zu ändern.

Fibre Channel: Viele Storage Area Networks basieren heute auf der Implementierung des Fibre-Channel-Standards. Die erreichten Datenübertragungsraten liegen heute bei 4 Gb/s und 8 Gb/s, was im Vollduplex-Betrieb für Datentransferraten von 800 MB/s ausreicht. Es sind jedoch auch geringere Datenübertragungsraten möglich, so war bis vor wenigen Jahren noch 1 Gb/s (1GFC) die maximale Datenübertragungsrate im Fibre Channel. Als Übertragungsmedium findet man Kupferkabel (hauptsächlich innerhalb von Storage-Systemen; überbrückt bis zu 30 m) und Glasfaserkabel (meist zur Verbindung der Storage-Systeme untereinander; überbrückt bis zu 10 km). Der Zugriff auf die Festplatten erfolgt blockbasiert.

Ähnlich wie bei klassischen Netzwerken, bei denen jede Netzwerkkarte eine MAC-Adresse hat, hat bei Fibre Channel jedes Gerät einen WWNN (World Wide Node Name) sowie jeder Port pro Gerät einen WWPN (World Wide Port Name). Es handelt sich dabei um einen 64-Bit-Wert (meist hexadezimal dargestellt), der jedes Fibre-Channel-Gerät eindeutig identifiziert. Fibre-Channel-Geräte können über mehr als nur einen Port verfügen, in diesem Fall hat das Gerät weiterhin nur eine WWNN, aber es besitzt WWPNs in der gleichen Anzahl wie es Ports besitzt. Die WWNN und die WWPN sind sich in der Regel sehr ähnlich.

Die Erweiterungskarten, die es den Servern ermöglichen, über Fibre Channel zu kommunizieren, werden als Host Bus Adapter (kurz: HBA) bezeichnet. Typische HBAs benötigen einen PCI-X-Steckplatz mit 64 Bit Busbreite und mindestens 100 MHz Taktrate.

iSCSI: iSCSI (internet Small Computer System Interface) ist ein Storage-over-TCP-Verfahren für Speichernetzwerke. Unterschieden wird das iSCSI-Target (der Server, der die Daten bereit stellt) und der iSCSI-Initiator, der auf einem System die Verbindung zu den Daten auf dem Target herstellt. –

iSCSI spezifiziert die Übertragung und den Betrieb direkter Speicherprotokolle nativ über TCP. Bei diesem Verfahren werden SCSI-Daten vom Initiator in TCP/IP-Pakete verpackt und über IP-Netze transportiert. Die verpackten SCSI-Kommandos gelangen so zu einem SCSI-Router, der auf Basis vorhandener Mapping-Tabellen das entsprechende Zielsystem (Target) zur Kommunikation mit der SCSI-Datenquelle auswählt.

iSCSI wird eingesetzt, um über eine virtuelle Punkt-zu-Punkt-Verbindung den Zugriff auf das Speichernetz zu ermöglichen, ohne dass eigene Speichergeräte aufgestellt werden müssen. Vorhandene Netzwerkkomponenten (Switch) können genutzt werden, da keine neue Hardware für die Knotenverbindungen nötig ist. Der Zugriff auf die Festplatten erfolgt blockbasierend, ist also auch für Datenbanken geeignet. Der Zugriff über iSCSI ist darüber hinaus transparent, erscheint auf Anwendungsebene also als Zugriff auf eine lokale Festplatte.

Nachteil der iSCSI-Technologie ist eine erhöhte CPU-Belastung der Server und mehr Interrupts pro Datenmenge für den Server. Es sind aber bereits Hardwarelösungen wie z. B. TCP/IP Offload Engine-Karten verfügbar, die das TCP/IP Overhead-Problem der CPU vermindern. Der Nachteil einer geringeren Grundgeschwindigkeit (iSCSI mit 1 Gbit/s im Vergleich zu Fibre Channel mit 4 Gbit/s) ist mit der Einführung von 10 Gigabit/s Ethernet und den damit erreichbaren Durchsätzen von mehr als 800 MByte/s nicht mehr gegeben.

Die Abbildung (rechts oben) zeigt ein „Enclosure“ mit 12 LFF-Platten; maximal sind 5 Enclosures möglich. Die Einbauhöhe pro „Enclosure“ beträgt 2U (2 Einheiten, Units).

Maximale Datenkapazität bei diesem Gerät: Es können SAS- und SATA-Platten im selben Einbaumodul nebeneinander verwendet werden.

- Bis zu 60 TB (bei Verwendung von 60 Stück 1 TB SATA Large Form Factor (3,5“)-Platten)

- Bis zu 29,2 TB (bei Verwendung von 99 Stück 300 GB SATA Small Form Factor (2,5“)-Platten

Max. 512 LUNs

Netzwerkanschluss: 1 Gbps Ethernet

SAN-Architektur: Typischerweise verwendet man zwei Switches (in der Abbildung sind 8 Gbps Fiber Channel-Switches dargestellt), um die Server mit dem Storage zu verbinden.

Man benötigt:

- Pro Server einen Host Bus Adapter (HBA)

- Fibre Channel-Switches

- Passende Kabel

- Storage-Modul (zB MSA 2000fc G2)

NAS-Gateway mit SAN

Sehr häufig wird auch ein SAN verwendet, um Datei-Daten zu speichern, wobei der Zugriff auf dieses Filesystem über einen NAS-Gateway erfolgt. Darunter versteht man ein Gerät, das üblicherweise keinen eigenes On-Board-Storage hat, sondern eine Verbindung zu einem SAN herstellt. Dabei agiert der Gateway als Übersetzer zwischen den dateibasierten NAS-Protokollen (NFS, CIFS/SMB) und den SAN-Blockzugriffsprotokollen wie iSCSI oder Fibre Channel.

Diese Hydridtechnologie kombiniert die Vorteile von NAS und SAN.

Theorie zur Partitionierung

Um Daten auf Datenträgern wie Festplatten, USB-Laufwerken etc. speichern zu können, müssen zwei Aktionen durchgeführt werden:

- Partitionierung: Bei der Partitionierung wird die Festplatte in Volumes (logische Laufwerke) unterteilt, auf die von Betriebssystemen aus zugegriffen werden kann.

- Formatierung: Die Formatierung bewirkt, dass auf einem Volume ein Dateisystem installiert wird. Dateisysteme sind notwendig, damit gespeicherte Daten physisch lokalisiert werden können.

Aufbau von Festplattensystemen

Die meisten Festplatten benutzen die Ober- und Unterseite der Scheiben und verfügen über mehrere Magnetscheiben. Die Schreib-/Leseköpfe für alle Oberflächen sind als Einheit montiert, sie können sich nicht unabhängig bewegen. Deshalb liegen die Spuren auf den Plattenoberflächen exakt übereinander. Ein Satz von übereinander liegenden Spuren trägt den Namen Zylinder (engl. cylinder).

Die drei Begriffe Zylinder (oder Spur), Kopf und Sektor spielen bei der Verwaltung von Festplatten eine zentrale Rolle. Denn über die Angabe dieser drei Werte lässt sich jede Stelle auf der Festplatte eindeutig adressieren. Diese CHS-Notation war bis etwa 1997 Standard und wurde auch danach noch für Festplatten kleiner 8 GByte verwendet. Die Zählweise beginnt bei Spuren und Köpfen bei 0, Sektoren starten bei 1. Statt des Begriffs Head ist oft auch Seite im Gebrauch, denn jeder Schreib-/Lesekopf korrespondiert ja mit einer Seite einer Magnetscheibe der Festplatte.

http://lnx.cx/docs/vdg-2/html/apb.html

adaptiert

Heute wird statt der CHS-Notation meist die Logische Blockadressierung (LBA, englisch „Logical Block Addressing“) verwendet. Die Blöcke der Festplatte werden im Gegensatz zur dreidimensionalen Zylinder-Kopf-Sektor-Adressierung (CHS) unabhängig von der Geometrie adressiert. Dabei werden die Blöcke beim LBA einfach gezählt, beginnend mit Null.

Bei LBA wird zwischen 28 und 48 bit unterschieden. Das 28-bit-LBA ermöglicht lediglich 137 GB große Festplatten. Als Erweiterung wird mit ATA-6 eine 48-bit-Adressierung (48-bit-LBA) eingeführt, mit der 281 474 976 710 656 Blöcke oder 144 PB adressiert werden können (512 Byte pro Block zugrunde gelegt). 48-bit LBA kommt bei den Festplatten mit Kapazitäten von mehr als 137 GB zum Zuge.

Die kleinste ansprechbare Einheit auf einer Festplattenpartition wird als Zuordnungseinheit (engl. allocation unit; auch als Cluster bezeichnet) bezeichnet. Die Unterteilung in Zuordnungseinheiten wird bei der Formatierung vorgenommen; die Clustergröße hängt vom verwendeten Dateisystem und der Gesamtpartitionsgröße ab. Dateien können immer nur Vielfache von Clustern belegen; beträgt die Clustergröße also 32 KB, so benötigt eine 33 KB große Datei 2 Cluster (31 KB bleiben ungenutzt).

Die tatsächlich belegte Größe auf einem Datenträger lässt sich in den Dateieigenschaften feststellen:

Man unterscheidet die Partitionsformate MBR und GPT:

MBR-Datenträger (Master Boot Record) können das Volume mit einer Größe von bis zu 2 Terabyte und bis zu 4 Primärpartitionen pro Datenträger (oder 3 Primärpartitionen, eine erweiterte Partition und eine unbegrenzte Anzahl logischer Laufwerke) verwalten.

GPT-Datenträger sind Datenträger des GPT-Partitionstyps (auch GUID-Partitionstabelle) mit einer Größe von maximal 18 Exabyte und bis zu 128 Partitionen. GUID Partition Table (GPT) ist ein Standard für das Format von Partitionstabellen auf Festplatten. Die Spezifikation ist Teil des EFI-Standards (EFI = Extensible Firmware Interface), der das BIOS in PCs ersetzen sollte. GPT ist somit der Nachfolger der MBR-Partitionstabellen.

Im Gegensatz zu MBR-Datenträgern werden alle Daten in Partitionen abgelegt – auch die für den Betrieb der Plattform zwingend notwendigen (MBR-Datenträger sichern diese in unpartitionierten oder versteckten Sektoren). GPT-Datenträger besitzen redundante Primär- und Sicherungspartitionstabellen; dies erhöht die Integrität der Daten.

Während im MBR ursprünglich mit dem Cylinder Head Sector-Verfahren adressiert wurde, verwendet die GPT Logical Block Addressing mit 64 Bit, so dass Festplatten bei 512 Byte Sektorgröße bis zu einer Gesamtgröße von 18 Exabyte adressiert werden und diese in bis zu 128 Partitionen aufgeteilt werden können.

MBR-Datenträger

Der Master Boot Record (MBR): Damit überhaupt mehrere Betriebssysteme auf einer Festplatte Platz finden, muss sich diese in Bereiche aufteilen lassen. Und die exakte Position dieser Bereiche muss an einer allgemein bekannten Stelle der Festplatte gespeichert sein: in Spur 0, Seite 0, Sektor 1. Dort ist bei jeder Festplatte im PC der Master Boot Record, kurz MBR, gespeichert.

| Adresse | Funktion / Inhalt | Größe (Bytes) | |

| hex | dez | ||

| 0x0000 | 0 | Boot-Loader | max. 440 |

| 0x01B8 | 440 | Disk-Signatur (seit Windows 2000) | 4 |

| 0x01BC | 444 | Null (0x0000) | 2 |

| 0x01BE | 446 | Partitionstabelle (4 Einträge à 16 Byte) | 64 |

| 0x01FE | 510 | 55hex (MBR-Signatur 0xAA55) | 2 |

| 0x01FF | 511 | AAhex | |

| Gesamt | 512 |

Partitionstabelle: Ein einzelner Eintrag in einer Partitionstabelle hat ebenfalls einen festen Aufbau und ist 16 Byte lang.

Ein solcher Eintrag ist wie in der folgenden Tabelle gegliedert.

| Speicherplatzadresse (Hexadezimal) | Größe (Bytes) | Inhalt der Partitionstabelle |

| 0x00 | 1 | Bestimmt, ob Partition gestartet werden kann oder nicht (80hex=bootfähig, 00hex=nicht bootfähig) |

| 0x01 | 3 | CHS-Eintrag des ersten Sektors |

| 0x04 | 1 | Typ der Partition (Dateisystem / Partitionstyp) |

| 0x05 | 3 | CHS-Eintrag des letzten Sektors |

| 0x08 | 4 | Startsektor (relativ zum Anfang der Festplatte, oder zur erweiterten Partitionstabelle) |

| 0x0C | 4 | Anzahl der Sektoren in der Partition |

Unbenutzte Einträge sind mit Nullen gefüllt.

In Byte 0 zeigt der Wert 80h (das oberste Bit ist gesetzt) an, dass diese Partition die Bootpartition mit einem Betriebssystem ist. Die Master-Boot-Routine wertet dieses Byte aus, um das Betriebssystem zu finden.

Die Bytes 1 bis 3 enthalten die Startposition der Partition: Kopf, Spur und Sektor. Das gilt für Festplatten bis zu einer Größe von 8 GByte. Größere Festplatten verwenden stattdessen die Bytes ab Position 7. Hier ist jeweils als 32-Bit-Zahl die Position des erstens Sektors der Partition (bezogen auf den Plattenanfang) und die Länge der Partition gespeichert. Mit den 32-Bit-Adressen sind Festplattengrößen bis 2048 GByte möglich.

Das Byte 4 spielt eine wichtige Rolle: Es enthält die Typkennung der Partition. Jedes Betriebssystem benutzt ein Dateisystem, um seine Verzeichnisse und Dateien auf der Festplatte zu organisieren. Der Typ gibt an, um welche Art Dateisystem es sich handelt. Die gebräuchlichsten Systeme sind in der folgenden Tabelle angegeben.

| Typbyte (hex) | Dateisystem |

| 0x00 | leer/unbenutzt |

| 0x01 | FAT12 (Floppy Disks) |

| 0x04 | FAT16 < 32 MiB |

| 0x05 | erweiterte Partition |

| 0x06 | FAT16 > 32 MiB |

| 0x07 | HPFS (OS/2) oder NTFS (Windows NT) |

| 0x0B | FAT32 |

| 0x0C | FAT32 mit BIOS-Extensions |

| 0x0E | FAT16 > 32 MiB mit BIOS-Extensions |

| 0x0F | erweiterte Partition mit BIOS-Extensions |

| 0x12 | OEM Partition für Konfiguration, Diagnose, BIOS-Erweiterung (für Microsoft-Betriebssysteme unsichtbar) |

| 0x42 | Dynamischer Datenträger |

| 0x82 | Linux Swap / Solaris 2.6 X86 bis Solaris 9 X86 |

| 0x83 | Linux Native |

| 0x8E | Linux LVM |

| 0xA5 | FreeBSD |

| 0xA6 | OpenBSD |

| 0xA9 | NetBSD |

Betriebssysteme der Windows NT-Reihe kümmern sich nicht um die Typkennung. Sie analysieren den Inhalt der Partition (genau gesagt: deren Partitionssektor/Bootsektor) und binden eine erkannte Partition, auf die sie zugreifen können, automatisch ein.

Es ist nicht notwendig, dass die Reihenfolge in der Partitionstabelle der physikalischen Reihenfolge auf der Festplatte entspricht. Die erste Partition im MBR kann durchaus in der Mitte der Festplatte bei Spur 600 beginnen.

Primäre und erweiterte Partitionen

Insgesamt bietet die Partitionstabelle des MBR Platz für vier Partitionen. Grundsätzlich gibt es zwei verschiedene Arten von Partitionen: primäre und erweiterte.

- Eine primäre Partition verweist direkt auf einen Bereich der Festplatte, der Dateien enthält. Meistens sind Betriebssysteme in primären Partitionen installiert, vor allem Microsoft-Systeme setzen dies sogar zwingend voraus. Die Definition ist etwas umständlich: Eine primäre Partition ist immer in der Partitionstabelle des MBR eingetragen und nicht durch die Typkennung als erweiterte Partition ausgewiesen.

- Eine erweiterte Partition enthält im Gegensatz dazu keine Dateien, sondern ist quasi ein Container für weitere Partitionen. Die Typkennungen 05h oder 0Fh weisen eine solche erweiterte Partition aus. Eine Partition innerhalb einer erweiterten Partition ist ein logisches Laufwerk. Durch diesen Kniff ist es möglich, mehr als vier Partitionen pro Festplatte zu realisieren. Für Microsoft-Betriebssysteme sind insgesamt bis zu 23 logische Laufwerke erlaubt, denn mehr Laufwerksbuchstaben ab C gibt es nicht.

Anmerkung: Über Laufwerkspfade, die eine Zuordnung einer Partition ohne eigenen Laufwerksbuchstaben zu einem Unterverzeichnis ermöglichen, ist es möglich, mehr als 23 logische Laufwerke anzusprechen. Außerdem können A und B auch für Festplattenpartitionen verwendet werden, falls keine Diskettenlaufwerke vorhanden sind.

Jede erweiterte Partition enthält einen Partitionssektor, der in seinem Aufbau exakt dem MBR entspricht. Allerdings fehlt hier die Master-Boot-Routine, es wird nur die Partitionstabelle genutzt. In diesem Partitionssektor haben wiederum vier Partitionen Platz. Wie erreicht man dann aber 23 logische Laufwerke? Eine erweiterte Partition nutzt immer nur zwei Einträge ihrer Partitionstabelle: Der Erste beschreibt die Position des logischen Laufwerks, der Zweite die Position einer zusätzlichen erweiterten Partition. Diese wiederum bietet Platz für ein logisches Laufwerk und so fort. So entsteht quasi eine Kette von erweiterten Partitionen, die jeweils ein logisches Laufwerk enthalten. Dabei ist die erste erweiterte Partition (die im MBR definiert ist) so groß, dass die anderen Partitionen darin Platz finden.

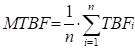

Bootsektor: Innerhalb jeder primären Partition gibt es einen weiteren Sektor, dessen Position immer gleich ist: der Bootsektor. Er liegt im ersten Sektor der Partition und ist damit leicht über die Einträge in der Partitionstabelle zu ermitteln. Jedes Betriebssystem verwendet hier seinen eigenen Aufbau, lediglich einige Daten sind immer identisch. Bei Microsoft-Betriebssystemen ist der Bootsektor weit gehend gleich, im Folgenden deshalb eine Beschreibung der Variante von Windows 98.

GPT-Datenträger

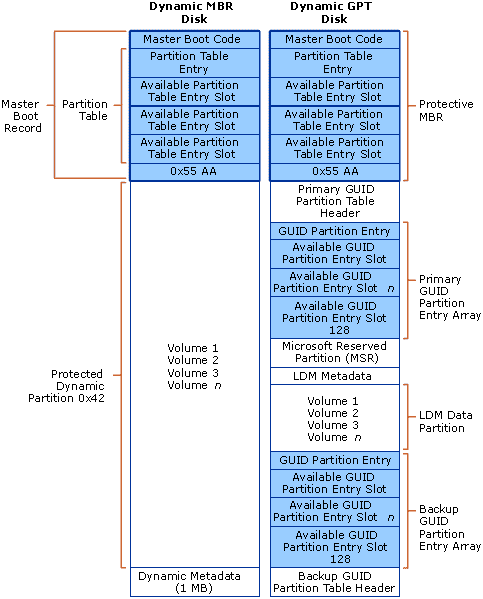

Vergleich der Partitionstabelle eines dynamischen MBR-Datenträgers mit einem GPT-Datenträgers

1. MBR-Schutzpartition (Protective MBR; 512 Byte groß)

Im ersten Block des Datenträgers befindet sich ein Master Boot Record, in dem der gesamte Platz als eine einzige MBR-Partition hinterlegt ist. Findet ein Betriebssystem, das nur MBR- aber keine GPT-Paritionstabellen lesen kann, den Datenträger, erscheint für dieses der gesamte Platz als belegt.

2. Header der GUID Partitionstabelle

Erst im zweiten Block beginnt die eigentliche GPT-Information mit der primären Partitionstabelle, die nochmals redundant in den letzten Block der Festplatte geschrieben wird (sekundäre Partitionstabelle). Da im Header der Partitionstabelle auch eine CRC32-Prüfsumme hinterlegt ist, kann im Fehlerfall schnell festgestellt werden, welcher der beiden Header der konsistente ist.

Im Header der GPT sind folgende Informationen abgelegt:

- Signatur (8 Bytes) – „EFI PART“

- Revision (4 Bytes) – 0x00010000

- Header-Größe (4 Bytes)

- Header-Prüfsumme (4 Bytes)

- Reservierter Platz (4 Bytes) – darf nicht belegt sein

- Position der primären Partitionstabelle (8 Bytes)

- Position der sekundären Partitionstabelle (8 Bytes)

- Position des ersten benutzbaren Blocks (8 Bytes)

- Position des letzten benutzbaren Blocks (8 Bytes)

- GUID (16 Bytes)

- Position der Partitionstabelle (8 Bytes)

- Anzahl der Partitionen (4 Bytes)

- Größe des Partitionseintrags (4 Bytes)

- Partitionstabllen-Prüfsumme (4 Bytes)

GUID Partitionseintrag (128 Byte pro Eintrag)

Im Partitionseintrag selbst sind folgende Daten hinterlegt:

- Partitionstyp (ID) (16 Bytes)

- GUID der Partition (16 Bytes)

- Beginn der Partition (8 Bytes)

- Ende der Partition (8 Bytes)

- Attribute (8 Bytes)

- Partitionsname (72 Bytes)

Im Gegensatz zu MBR-Datenträgern werden alle Daten in Partitionen abgelegt – auch die für den Betrieb der Plattform zwingend notwendigen (MBR-Datenträger sichern diese in unpartitionierten oder versteckten Sektoren).

Formatierung

Beim Formatieren wird ein sogenanntes Dateisystem (File System) auf die Partition geschrieben. Dateisysteme sind dafür verantwortlich, einem logischen Dateinamen (einschließlich einer hierarchischen „Ordnerstruktur“) den physischen Speicherplatz der Datei auf einem Laufwerk zuzuordnen. Es besteht daher aus einer Datenbank (auch: Tabelle), in der diese Zuordnungen gespeichert sind.

In Microsoft-Windows-Betriebssystemen werden folgende Dateisysteme unterstützt:

| Dateisystem | Maximale Partitionsgröße | Berech-tigungen | Clustergröße |

| FAT12 (File Allocation Table): Wurde für Disketten entwickelt und ist bis heute auf 3,5“-Disketten in Verwendung | 16 MiB | – | 512 B – 4 KiB |

| FAT16 (File Allocation Table) | 2 GiB (unter Windows NT 4 GiB) | – | 4 KiB – |

| FAT32 (verbesserte Variante von FAT, Microsoft unterstützt maximal 32 GiB-FAT32-Partitionen, um NTFS zu fördern); maximale Dateigröße 4 GiB. | 32 GiB (theoretisch 16 TiB) | – | 512 B – 128 KiB |

| exFAT (Extended FAT): speziell für Flash-Laufwerke entwickelt | 512 TiB (theoretisch 64 ZiB) | – | 4 KiB – 32 MiB |

| NTFS (NT File System): Standard-Dateisystem für Festplatten | 256 TiB (theoretisch 16 EiB) | ACL | 4 KiB – 2 MiB |

| ReFS (Resilient File System, „robustes Dateisystem”): maximale Dateigröße 262144 EiB, bessere Fehlerkorrektur, nicht für Windows 10 Home; Einträge basieren auf einem B-Tree-System. | 1 YiB (280 Byte) | ACL | 4 KiB oder 64 KiB |

| UDF (Universal Disk Format): vor allem für DVDs verwendetes, plattformunabhängiges Dateisystem |

In Linux-Systemen sind eine Reihe weiterer Dateisysteme in Verwendung, zum Beispiel:

| ext4 (Extended File System 4. Generation, 2008 veröffentlicht): Journaling-Dateisystem, unterstützt transparente Verschlüsselung und Zugriffskontrolllisten. Standarddateisystem von Ubuntu. | 1 EiB | ACL | 1 KiB, 2KiB oder 4 KiB |

| XFS: von Silicon Graphics Inc. (SGI) entwickeltes Dateisystem | 16 EiB | ACL | 512 B – 64 KiB |

| Btrfs (BTree File System): von Oracle 2007 veröffentlicht; Copy-on-Write-Dateisystem; Standard bei SuSE Linux Enterprise Server 12, transparente Verschlüsselung | 16 EiB | ACL | 1 KiB, 2KiB oder 4 KiB |

Theorie zu Dateisystemen

FAT-Dateisysteme (File Allocation Table)

Das FAT-Dateisystem verwaltet eine Dateizuordnungstabelle, in der Informationen über die Position aller Dateien gespeichert sind. Aufgrund ihrer grundlegenden Bedeutung für das Dateisystem existieren in der Regel zwei Kopien, um bei Datenverlust noch immer eine funktionsfähige andere FAT zu haben. Mit diversen Programmen ist eine Datenwiederherstellung in vielen Fällen möglich.

FAT-Versionen

- FAT12 (wurde für Disketten aller Art verwendet)

- FAT16 (wird heute meist auf allen Arten von mobilen Datenträgern verwendet, die kleiner als 2 GiB sind)

- FAT32 (wird z. B. in allen Arten von mobilen Speichern von mehr als 2 GB Kapazität genutzt. Von neueren DOS-Systemen, Windows 9x/ME und Windows NT-Versionen ab 2000 unterstützt. FAT32 verwendet 32 bit-Clusterkennungen, reserviert allerdings die oberen 4 bit, somit sind 28 bit-Clusteradressen im Einsatz. Die Maximalgröße eines FAT32-Clusters beträgt 32 KB. FAT32 hätte theoretisch also die Fähigkeit, 8 TB große Partitionen zu adressieren; die Implementierung ab Windows 2000 begrenzt die Maximalgröße für FAT32-Partitionen allerdings auf 32 GB. (Sollte eine FAT32-Partition größer als 32 GB unter Windows 9x/ME angelegt worden sein, dann wird sie natürlich auch von neueren Betriebssystemen unterstützt.) Ein Volume muss mindestens 65 527 Cluster enthalten, damit das FAT32-Dateisystem verwendet werden kann.

Genauere Informationen über die Beschränkungen des FAT32-Dateisystems findet man im Microsoft-Knowledge Base-Artikel 184006.

Größe der Zuordnungseinheiten für FAT16

| Partitionsgröße | FAT16 |

| (0 … 32) MB | 512 Byte |

| (33 … 64) MB | 1 KB |

| (65 … 128) MB | 2 KB |

| (129 … 256) MB | 4 KB |

| (257 … 512) MB | 8 KB |

| (512 … 1023) MB | 16 KB |

| (1 … 2) GB | 32 KB |

| (2 … 4) GB | 64 KB (nur unter Windows NT 4.0 unterstützt) |

| > 4 GB | nicht unterstützt |

Größe der Zuordnungseinheiten für FAT32

| Partitionsgröße | FAT32 |

| (0 … 512) MB | nicht unterstützt |

| (513 … 8192) MB | 4 KB |

| (8 … 16) GB | 8 KB |

| (16 … 32) GB | 16 KB |

| 32 GB | 32 KB |

NTFS-Dateisystem (New Technology File System)

Aus Sicht des Dateisystems ist alles Teil einer Datei, auch die Informationen des Systems. Die Hauptdatei ist die MFT (Master File Table). In dieser Datei befinden sich die Einträge, welche Blöcke zu welcher Datei gehören, die Zugriffsberechtigungen und die Attribute. Jede Eigenschaft einer Datei ist unter NTFS ein Attribut, auch der eigentliche Dateiinhalt.

Sehr kleine Dateien und Verzeichnisse werden in der MFT direkt abgespeichert. Größere Dateien werden dann als Attribut in einem Datenlauf gespeichert.

Beim Formatieren der Festplatte wird für die MFT ein fester Platz reserviert, der nicht von anderen Dateien belegt werden kann. Wenn dieser voll ist, beginnt das Dateisystem freien Speicher vom Datenträger zu benutzen, wodurch es zu einer Fragmentierung der MFT kommen kann. Standardmäßig wird ein reservierter Bereich von 12,5 % der Partitionsgröße angenommen. Es sind jedoch auch Werte von 25 %, 37,5 % und 50 % konfigurierbar.

Beim Speichern von Meta-Daten wird ein Journal geführt. Das bedeutet, dass eine geplante Aktion zuerst in das Journal geschrieben wird. Dann wird der eigentliche Schreibzugriff auf die Daten ausgeführt und abschließend wird das Journal aktualisiert. Wenn ein Schreibzugriff nicht vollständig beendet wird, zum Beispiel wegen eines Stromausfalls, muss das Dateisystem nur die Änderungen im Journal zurücknehmen und befindet sich anschließend wieder in einem konsistenten Zustand.

Bis Windows 8 wurde das Journal $LogFile in der Version 1.1 geführt, Windows 8.1/Windows 10 verwenden eine neue Version 2.0, die mit der älteren Version inkompatibel ist.

NTFS verwendet 64 bit-Clusterkennungen. Das würde eine Maximal-Partitionsgröße von 16 EB (= 6,7 Mrd. GB) möglich machen; allerdings begrenzt Windows die Größe eines NTFS-Volumes auf einen Umfang, der mit 32 bit-Clusteradressen adressierbar ist, also auf ca. 256 TB. In diesem Fall beträgt die Clustergröße 64 KB.

NTFS-Versionen

- NTFS 1.X – Windows NT 3.1, 3.5 und 3.51

- NTFS 2.X – Windows NT 4.0

- NTFS 3.0 – Windows 2000

- NTFS 3.1 – Windows XP, Windows 2003, Windows Vista, Windows Server 2008 (R2), Windows 7, Windows 8, Windows 8.1, Windows 10. Diese Version wird manchmal auch als Version 5 bezeichnet.

Größe der Zuordnungseinheiten für NTFS

| Partitionsgröße | Voreingestellte NTFS-Clustergröße |

| (0 … 512) MB | 512 Byte |

| (513 … 1024) MB | 1 KB |

| (1025 … 2048) MB | 2 KB |

| > 2 GB | 4 KB |

Größere Zuordnungseinheiten sind beim Formatieren manuell konfigurierbar. So ist etwa für Volumes, die SQL Server-Datenbanken aufnehmen sollen, eine Größe von 64 KB empfehlenswert, da SQL Server immer in 64 KB-Einheiten liest bzw. schreibt.

| Beschreibung | FAT16 | FAT32 | NTFS |

| Maximale Dateigröße | 232 – 1 Byte | 232 – 1 Byte | 244 – 64K bytes (geplant bis 264 – 1 Byte) |

| Anzahl Dateien pro Volume | 216 | 228 | 232 – 1 |

| Minimale Volume-Größe | 4085 Zuordnungseinheiten | 65535 Zuordnungseinheiten | 1 MB |

| Maximale Volume-Größe | 65536 – 12 Zuordnungseinheiten; maximale Partitionsgröße: 2 GB | Theoretisch: 228 Zuordnungseinheiten. Ab Windows 2000: Formatierung bis 32 GB, Zugriff auf größere Einheiten Windows ME: Bis zu 228 – 12 Zuordnungseinheiten Windows 95/98: 4,177,918 Zuordnungseinheiten | Theoretisch: 264 Zuordnungseinheiten Aktuell: 232 Zuordnungseinheiten |

| Größe einer Zuordnungseinheit | Für alle Dateisysteme: Windows NT-Linie: zwischen 29 (512) und 216 (65536) Byte Windows 95/98/ME: zwischen 29 (512) und 215 (32768) Byte | ||

| Verzeichnisgröße | 216 – 2 physikalische Verzeichniseinträge, allerdings spezielle Einschränkungen für das Stammverzeichnis | 216 – 2 physikalische Verzeichniseinträge | Keine Begrenzung |

ReFS (Resilient File System)

Das ReFS (Resilient File System, deutsch etwa „robustes Dateisystem“) ist in der Lage, defekte Dateien automatisch zu reparieren. Außerdem gilt ReFS im Vergleich zu NTFS als wesentlich unempfindlicher gegenüber Abstürzen des Betriebssystems oder dem Ausschalten des Servers ohne vorheriges Herunterfahren. Das neue Dateisystem arbeitet optimal mit den neuen Speicherpools zusammen. Speicherpools erlauben das Zusammenfassen mehrerer physischer Datenträger zu einem logischen Pool.

Das neue Dateisystem ReFS ist auf Windows 10 und Windows Server 2016/2019 verfügbar, wobei das Erstellen von ReFS-Volumes nur für Windows 10 Pro/Enterprise-Versionen möglich ist. Neben der automatischen Korrektur benötigt das neue Dateisystem keine langen Ausfallzeiten mehr durch Reparaturmaßnahmen und kann zur Reparatur heruntergefahren werden.

In ReFS lassen sich Metadaten und Prüfsummen von Dateien wesentlich effizienter integrieren als in Vorgängerversionen. Das Dateisystem protokolliert Änderungen in Dateien und kann ursprüngliche Änderungen speichern. NTFS überschreibt ältere Versionen von Metadaten und Prüfsummen unwiederbringlich. Das heißt, Daten gehen nicht verloren, sondern können im Dateisystem wieder hergestellt werden, auch wenn Anwender Dateien geändert haben. Das funktioniert ähnlich wie bei den Schattenkopien in NTFS, ist aber nicht vom Erstellen solcher Schattenkopien abhängig, sondern läuft ständig im Hintergrund. Die Technik entspricht in etwa den transaktionalen Datenbanken. Der Vorteil dabei ist, dass auch bei Stromausfällen keinerlei Daten auf ReFS-Datenträgern verloren gehen können.

Allerdings handelt es sich bei ReFS um kein Dateisystem, das Daten in Datenbanken speichern kann. Microsoft hat nur einige Vorteile des transaktionalen Systems integriert. ReFS unterstützt keine Wechseldatenträger.

ReFS trägt auch den immer größeren Dateien und Festplatten Rechnung. Das System unterstützt eine in nächster Zeit unerreichbare Größe von Dateien und Festplatten, die weit über die Möglichkeiten von NTFS hinausgehen. Laut Angaben von Microsoft beherrschen ReFS-Datenträger eine Größe von 16 Exabyte. Ordner auf ReFS-Dateiträgern können nahezu eine unbegrenzte Anzahl Dateien speichern, und auch die Anzahl der Ordner kann mehrere Trillionen betragen. Dateinamenkönnen eine Länge von 32.000 Zeichen erreichen. Die Leistung soll durch große Dateien aber nicht einbrechen, dafür sorgt die neue Technologie im Hintergrund, die Daten effizienter speichert.

Wie NTFS lassen sich auch in ReFS Berechtigungen auf Basis der Zugriffssteuerungslisten (ACL) vergeben. Daten können Anwender weiterhin mit BitLocker verschlüsseln. ReFS unterstützt aber keine Komprimierung von Dateien über das Dateisystem mehr, und auch keine Verschlüsselung einzelner Dateien. Auch Quotas auf dem Datenträger unterstützt ReFS nicht. Microsoft will konsequent wenig verwendete Features aus dem Dateisystem entfernen.

Anwender bemerken bei der Verwendung des neuen Dateisystems keinen Unterschied zu NTFS, die Bedienung ist vollkommen transparent. Auch Entwickler können die standardmäßige API von NTFS für den Zugriff auf ReFS nutzen. Laut Microsoft sollen auch keine Inkompatibilitäten mit aktuellen Anwendungen bestehen. Programme, die mit NTFS funktionieren, sollen auch mit ReFS laufen. Das liegt nicht zuletzt daran, dass die Zugriffsschnittstelle (API), mit der das Dateisystem kommuniziert, dem von NTFS entspricht. Nur die zugrunde liegende Technik ist unterschiedlich. Die Master File Table (MFT) auf ReFS-Datenträgern unterscheidet sich ebenfalls von NTFS.

Magnetband

Magnetbänder wurden früher als übliches Speichermedium (statt Disketten und Festplatten) eingesetzt, heute dienen sie Archiv- und Sicherungszwecken.

Ein Magnetband besteht aus einer Kunststoffschicht mit einer darauf aufgebrachten magnetisierbaren Eisenoxidschicht. Die Zellen werden bitweise in neun Spuren durch unterschiedliche Magnetisierrichtungen dargestellt.

Bauweisen: Für Großrechenanlagen sind noch vereinzelt Magnetbandspulen erhältlich, meist verwendet man heute Magnetbandkassetten.

(Anmerkung: Genauso funktionieren Tonbandkassetten und Tonbänder, nur dass man bei Studioaufnahmen bis 24 Spuren für die einzelnen Instrumente benützt)

Das Schreiben erfolgt durch Magnetisieren mit einen Elektromagneten, das Lesen durch elektromagnetische Induktion.

Die Zeichen einer Datenmenge bilden als Gesamteinheit einen Block. Alle zusammengehörenden Blöcke stehen auf einem Bandabschnitt, der Datei genannt wird.

Gütekriterien

- Bauweise

- Schreibdichte

- Spurenzahl

- Länge

- Übertragungsrate

Für Sicherungskopien von Festplatten verwendet man besonders leistungsfähige Magnetbänder (meist DAT-Kassetten = „digital audio tape“, die bisher vorwiegend im Audiobereich verwendet wurden), so genannte DAT-Streamer mit einer Speicherkapazität zwischen 500 MB und 20 GB.

Bekannte Band-Technologien sind:

- DDS (Digital Data Storage): beruht auf einem Format aus der Audiotechnik, wurde 1989 von Sony und HP entwickelt. Verwendet Schrägspuraufzeichnung. DDS7-Medien (DAT320) haben eine Kapazität von 160 GB pro Kassette. Solche Kassetten wurden früher in kleineren Netzwerken häufig verwendet, die Bedeutung schwindet allerdings auf Grund der immer größeren Datenmengen.

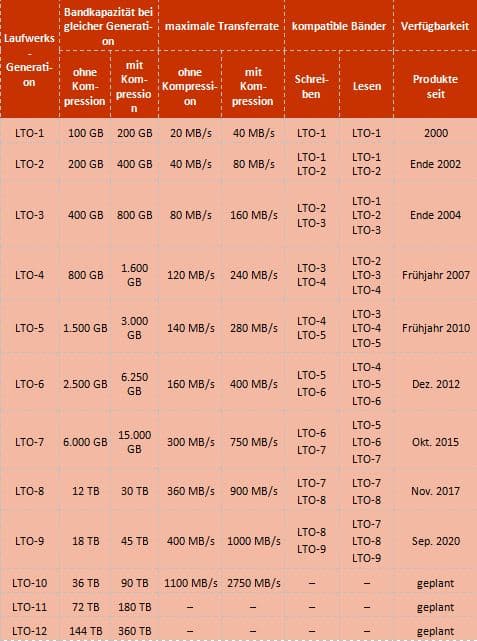

- LTO (Linear Tape Open): Wird von einem Konsortium weiterentwickelt, dem unter anderen Seagate, HP und IBM angehören. Stellt heute die am weitesten verbreitete Bandtechnologie dar. Kassetten können 15 bis 30 Jahre archiviert werden. Die Datenspeicherung erfolgt im Format LTO-Ultrium.

Heute produzieren nur mehr Fujifilm und Sony aktuelle LTO-Magnetbandkassetten.

Das Band in einer LTO-9-Bandkassette ist 1035 m lang und 5,6 µm dick.

Ein Sonderfall sind die als Scheck-, Bankomat- und Identifikationskarten verwendeten Magnetstreifenkarten. Magnetstreifenkarten bestehen aus Vollplastik, haben die Standardgröße 85,6 mm x 54 mm x 0,76 mm; in die Rückseite ist ein meist 0,5“ breiter Magnetstreifen integriert, der auf drei parallelen Spuren maximal 1394 Bit Daten aufnehmen kann. Heute durch einen Speicherchip ersetzt oder ergänzt.

Memory Cards

Memory Cards werden zunehmend bei mobilen Geräten statt den Festplatte eingesetzt. Sie bestehen aus mehreren Flash-Memory-Chips. Bei derartigen Chips handelt es sich um EEPROMs, haben Abmessungen von 1 cm x 1 cm x 0,1 cm.

Memory Cards können sowohl als externer Speicher (statt Festplatten) als auch als interner Speicher (RAM-Ersatz) verwendet werden.

Vorteile: stoßunempfindlich, geringe Abmessungen

Nachteile: nach 1 Million Schreib-/Lesezyklen ist die Card verschlissen, da sich durch die Löschvorgänge die Chips selbst zerstören.

Für den Einsatz der Flash-Chips als Massenspeicher entwickelte Microsoft das Flash File System als Betriebssystemerweiterung. Damit können Flash-Memory-Karten wie Festplatten verwendet werden.

Um die Kompatibilität der Memory Cards zu gewährleisten, wurde die PCS-Norm (PC Card Standard; früher: PCMCIA) entwickelt, der sowohl die Bauformen der Karten als auch Ein-/Ausgabevorgaben festlegt. Auf Grund dieser Norm können auch Faxmodems, Netzwerkkarten, Mini-Festplatten usw. betrieben werden, sodass diese Norm als Schnittstellennorm bezeichnet werden kann (siehe dort!).

USB-Memory Sticks

Die größte Überraschung auf dem Speichermarkt in den Jahren 2002/2003 war der Markterfolg der USB-Memory Sticks, die meist auf Flash-Memory-Technologie aufbauen.

USB-Sticks werden heute als kleine, mobile Datenträger zum Transport umfangreicherer Dokumente und Präsentatitonen.

Ein USB-Memory Stick lässt sich wie eine normale Festplatte lesen und beschreiben. Einfach – auch bei laufendem Betriebssystem – in den USB-Port stecken, schon steht ein Laufwerk mehr zur Verfügung. Der Memory Stick bietet deutlich mehr Speicherplatz als eine Diskette und lässt sich per Kennwort schützen. USB Memory Sticks gibt es (Stand: 2017) in Speichergrößen bis 2 TB. Als Schnittstellenstandard wird heute meist USB 3.0, fallweise schon USB 3.1 unterstützt.

Es ist auch möglich, Betriebssysteme von USB-Sticks zu booten (falls diese Möglichkeit vom BIOS unterstützt wird).

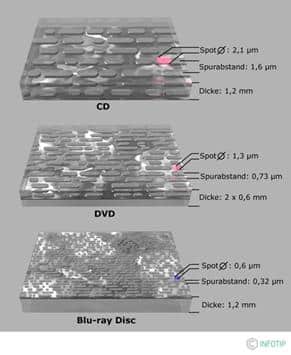

Optische Medien

Optische Speichermedien sind meist runde Scheiben aus transparentem Kunststoff (Polycarbonat, Acryl) mit einem Durchmesser von 7,6-30 cm und 1,2 mm Dicke. Je nach System sind die Information entweder in einer spiralförmigen Spur oder in mehreren konzentrischen Spuren abgelegt. Der Spurabstand beträgt z.B. bei der CD 1,6 µm. Die Informationen selbst sind als Vertiefungen („Pits“) in der Oberfläche („Land“) der Disk eingepresst. Die Pressformen (Stempel) zur Herstellung von optischen Medien werden von gläsernen Mutterdisks (glass master) abgeleitet, in die die Pits mittels starker Laser (z.B. CO2-Laser) gebrannt wurden.

Nach dem Pressen werden die Scheiben auf der Prägeseite mit einem reflektierenden Material, meist Aluminium, beschichtet. Zum Schutz vor Umwelteinflüssen wird die reflektierende Schicht anschließend per Spin-Coating mit einem Schutzlack überzogen und meist im Siebdruckverfahren bedruckt.

Zugriffstechnik

Zum Auslesen der Disk rotiert diese mit 200 bis zu 10 000 Umdrehungen pro Minute. Abhängig vom System kommen unterschiedliche Geschwindigkeitsregelungen zur Anwendung.

- CLV-Verfahren (Constant Linear Velocity = konstante Lineargeschwindigkeit): Dabei nimmt die Umdrehungsgeschwindigkeit der Disk abhängig von der Position des Laser-Pickup von Innen (z.B. CD: 495 U/min) nach außen (CD: 212 U/min) hin ab. Somit bleibt die vom Pickup gelesene Datenrate über das ganze Medium hinweg konstant.

- CAV-Verfahren (Constant Angular Velocity = konstante Winkelgeschwindigkeit): Hier bleibt die Umdrehungsgeschwindigkeit der Disk immer konstant. Dieses hat zur Folge, dass die gelesene Datenrate innen niedriger ist als am äußeren Rand der Disk.

Das Auslesen der auf der optischen Disk befindlichen Informationen wird mit einem Laserstrahl vorgenommen. Die Wellenlänge (= Farbe) des Lasers muss zu den mechanischen Eigenschaften, genauer die Tiefe der Pits auf dem Medium, angepasst sein. Wie in Abb. 1.1.5 dargestellt, sollte die Tiefe der Pits auf dem Medium etwa ein Viertel oder die Hälfte der Wellenlänge des Lasers betragen.

Bei digitalen Signalen stellen die Pits und Land keineswegs die Bits direkt dar. Vielmehr liegt die Information in den Zustandsübergängen. So kodiert der Übergang von Pit nach Land oder von Land nach Pit eine 1, während keine Änderung eine Reihe von Nullen erzeugt.

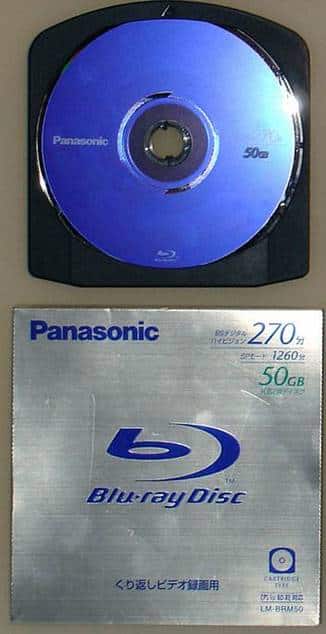

Bei wiederbeschreibbaren optischen Datenträgern wird die Phase Change-Technologie eingesetzt. handelt es sich um ein wiederbeschreibbares Medium, entwickelt von Panasonic. Ein Laserstrahl verändert hier die Reflexionseigenschaften der Oberfläche (Tellur-Legierung), wobei man diesen Vorgang beliebig oft umkehren und wiederholen kann.

CD-ROM

Die erste CD (compact disk) wurde 1979 von Philips in Eindhoven vorgestellt, 1982 kam sie auf den Markt.

Um von einer CD booten zu können, ist ein BIOS nötig, welches den El Torito-Standard erfüllt.

In der Zwischenzeit gibt es – technisch gesehen – verschiedene CD-Medien, die alle das gleiche Aussehen haben: runde 5¼“-Scheiben, die mit Acryllack überzogen sind.

Qualitätskriterien für die Laufwerke

- Zugriffsgeschwindigkeit: Wird in Millisekunden angegeben. Sollte bei modernen Laufwerken nicht über 150 ms liegen.

- Rotationsgeschwindigkeit: Meist wird der Multiplikationsfaktor auf die „Normalgeschwindigkeit“ der ersten Laufwerke (Single-Speed = 150 kByte/s) angegeben. Derzeit sind erhältlich: (Double Speed (2x), Triple Speed (3x), Quad Speed (4x), Hex Speed (6x), 8x, 12x, 24x, 32x nicht mehr im Handel) 40x, 50x. Die Rotationsgeschwindigkeit nimmt direkten Einfluss auf die maximal mögliche Datentransferrate.

Die CD kam ursprünglich aus der Musik-Industrie um die Magnetbänder abzulösen. Die CD-ROM ist also eigentlich ein Nebenprodukt der Musik-CD. Der Anwender kann sie nicht selbst beschreiben oder löschen. Eine CD besteht aus einer Polycarbonat-Scheibe (spezieller Kunststoff), die mit Aluminium beschichtet ist. In diese Alu-Schicht werden kleine Vertiefungen geätzt. Während an der Oberfläche der Laserstrahl gestreut wird, wird in den Ätzvertiefungen der Strahl genau auf ein Empfangsgerät gespiegelt, womit sich die beiden digitalen Zustände ergeben. Die Datenkapazität beträgt ca. 700 MB. Die Zugriffszeiten liegen im Bereich von ca. 0,15 s. Mit einem CD-ROM-Gerät können auch normale Audio-CDs abgespielt werden. Für CD-ROMs gibt es einige Standards: die beiden älteren werden als „Mode 1“ und „Mode 2“ bezeichnet, der neue als „CD-ROM/XA“, wobei XA für „extended architecture“ steht.

Dateisystem: Das ISO-9660-Format der CD-ROM kann lediglich 1 GB verwalten und hat zur Wahrung der Kompatibilität zu verschiedenen Betriebssystemen einige Einschränkungen:

- Dateibezeichnung 8 Zeichen lang, dazu 3 Zeichen für die Dateierweiterung

- Es können nicht alle Zeichen (v.a. Sonderzeichen) für die Namensvergabe verwendet werden.

- Es sind (inkl. Stammverzeichnis) nur 8 Verzeichnisebenen möglich.

Eingesetzt werden CD-ROMs zum Datentransfer (Installationsprogramme), für große Datenmengen im Grafikbereich (Foto-CDs, Computerspiele) und im Datenbankbereich (Rechtsdatenbank usw).

CD-R

CD-Recordable. Diese Datenträger sind WORM-Medien (Write Once Read Multiple), das heißt, sie können nur einmal beschrieben und dann nur mehr gelesen werden. Dieses Verfahren eignet sich vor allem zur Archivierung von Daten, die keiner Veränderung mehr unterworfen sind. Die CD-R gilt als einziges rechtlich völlig abgesichertes Speichermedium und wird vor Gericht als Beweismittel anerkannt.

Die Daten werden per Laserstrahl in das Trägermedium eingebrannt. Geräte dafür („CD-Brenner“) sind bereits zu relativ mäßigen Preisen erhältlich.

Die Standard-CD-Rs haben die übliche Größe von 5¼“ und fassen 600 – 720 MB. Für Großanlagen sind allerdings auch Medien in den Größen 8“, 12“ und 14“ erhältlich, die mehrere Gigabyte an Daten fassen.

Ausbaufähig: „JukeBox“ (Datenvorrat bis 1,5 TB, Wartezeit max. 2 Sekunden).

CD-RW

CD-Read & Write. Wiederbeschreibbares optisches Medium mit gleicher Speicherkapazität wie CD-R.

DVD (Digital Versatile Disk)

Die DVD wurde ursprünglich entwickelt, um den veralteten analogen VHS-Standard bei Videokassetten abzulösen (ursprüngliche Bedeutung von DVD „Digital Video Disk“).

Die DVD fasst bis zu fünfundzwanzigmal mehr Daten als eine CD. DVD ist eine Fusion von SDD (Super Density Disk) und MMCD (Multi Media CD).

Prinzipiell ist die DVD ein holografischer 3D-Speicher.

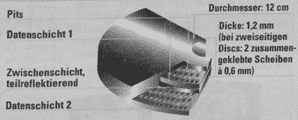

Die DVD ist ein vielschichtiges Medium. Die Kapazität einer einzigen DVD-Datenschicht ist mit 4,7 GB etwa siebenmal so hoch wie die einer CD. Die Norm sieht auch eine einseitige Zweischichten-DVD mit insgesamt 8,5 GB Kapazität oder eine zweiseitige Zweischichten-DVD mit 17 GB vor. (Theoretisch wären auch zehnschichtige DVDs denkbar!)

Die siebenfache Steigerung der Datendichte pro Schicht ist auf geringere Pit-Abmessungen, einen engeren Spurabstand (CD: 1,6 µm; DVD: 0,74 µm) sowie eine kürzere Wellenlänge des Laserlichts zurückzuführen. Die Lasersysteme herkömmlicher CD-Wiedergabegeräte und CD-ROM Laufwerke senden ein unsichtbares Infrarotlicht mit einer Wellenlänge von 780 Nanometern aus. Die neuen DVD-Player und DVD-ROM-Laufwerke arbeiten dagegen mit rotem Laserlicht von 650 und 635 Nanometern Wellenlänge.

Die kürzeren Wellenlängen korrelieren mit den kleineren, dichter angeordneten Pits: Das sind die Vertiefungen auf der CD/DVD, die die Information tragen. Zudem ist das neue Lasersystem mit einer Optik ausgestattet, die den Laser schärfer bündelt. Einen einseitige Zweischichten-Disk besteht aus zwei Pit-Schichten. Die untere ist mit Aluminium verspiegelt, eine teildurchlässige Folie trennt die beiden. Der Laser durchdringt die Folie und tastet zunächst die verspiegelte Ebene ab. Anschließend fokussiert er auf die obere Schicht und liest deren Daten aus. Ein elektronischer Puffer sorgt für fließende Übergänge.

„Single-Speed“ bedeutet bei DVD-Laufwerken 1350 KByte/s.

DVD-Player, die auch CDs lesen können, arbeiten mit Laserlicht verschiedener Wellenlänge.

Dateisystem: UDF (Universal Disk Format), kann mehrere Terabyte adressieren.

Datenformate, Weiterentwicklung

Die Formate haben sich auf Grund der verschiedenen Möglichkeiten der Nutzung der DVD ergeben (Daten, Video, Audio, etc).

Übersicht der DVD-Typen

| DVD-Typ | Seiten | Schichten | Kapazität | |

| DVD-5 | 1 | 1 | 4,7 GB | – |

| DVD-9 | 1 | 2 | 8,5 GB | – |

| DVD-10 | 2 | 1 | 9,4 GB | – |

| DVD-14 | 2 | 1/2 | 13,24 GB | Hybrid DVD |

| DVD-18 | 2 | 2 | 17 GB | – |

| DVD-1 | 1 | 1 | 1,5 GB | 8 cm |

| DVD-2 | 1 | 2 | 2,7 GB | 8 cm |

| DVD-3 | 2 | 1 | 2,9 GB | 8 cm |

| DVD-4 | 2 | 2 | 5,3 GB | 8 cm |

Beschreibbare DVDs