Artificial Intelligence und die berüchtigte Blackbox

Eine der größten Hürden für die Verwendung von Machine Learning im Alltag ist die schwere Nachvollziehbarkeit des Outputs von Artificial Intelligence Algorithmen. Input wird in eine Blackbox eingespielt – und ausgespien wird ein unerklärbares Ergebnis. Oberbegriffe wie Machine Learning oder Artificial Intelligence bekommen dadurch einen ominösen Charakter. Zusätzlich verstärken Medienberichte über diskriminierende Artificial Intelligence das Gefühl des Unkalkulier- und Unberechenbaren. https://en.unesco.org/artificial-intelligence/ethics/cases

Damit Artificial Intelligence in unserem Alltag Akzeptanz findet und ihr positives Potenzial gänzlich entfalten kann, müssen ihre Entscheidungen für uns Menschen nachvollziehbar sein. Es gibt bereits mehrere vielversprechende Methoden, die die Prognosen von Machine Learning Algorithmen hinterfragen und erklären können. Besonders faszinierend ist die Methode der Feature Visualization. Diese ermöglicht es, die Denkweise von Machine Leaning Algorithmen – streng genommen von Neuronalen Netzwerken – zu veranschaulichen. Die Architektur dieser Netzwerke ist an das menschliche Gehirn angelehnt und soll das Lernen und Kommunizieren über ein neuronales Netz nachempfinden. Für alle die noch wenig Erfahrung mit künstlichen Neuronalen Netzwerken haben, ist hier eine vereinfachte Erklärung dieser. Die Kernkonzepte, die ich hier vorstellen werde, werden uns im folgenden Abschnitt helfen die Methodik der Feature Visualization besser verstehen zu können:

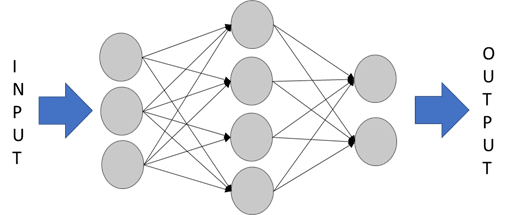

Ein Neuronales Netzwerk versucht Ähnlichkeiten zwischen Inputs zu erkennen und lernt diese bestimmten Kategorien zuzuordnen. Es besteht aus miteinander kommunizierenden Neuronen, die in der Regel alle ähnlich aufgebaut sind. Ein Neuron besteht aus zwei auszuführenden Funktionen.

1. Der erhaltene Input wird mit einem gewichtenden Faktor multipliziert. Die Stärke der Gewichtung wird während eines Trainingsprozesses optimiert.

2. Anschließend summiert das Neuron alle gewichteten Inputs und wendet eine sogenannte „Aktivierungsfunktion“ an. Das Ergebnis der Aktivierungsfunktion entscheidet, wie stark ein Neuron aktiviert wird und daher auch wie stark der Output eines einzelnen Neurons das Gesamtergebnis beeinflusst – ein stärker aktiviertes Neuron übt größeren Einfluss auf das Ergebnis aus.

Ein Input durchwandert das Neuronale Netz, wobei verschiedene Eigenschaften unterschiedlich stark gewichtet, summiert und aktiviert werden. Aus dem modifizierten Input entsteht schlussendlich ein Output, der im besten Fall korrekt und nützlich ist.

Feature Visualization

Das Konzept der Feature Visualization hilft Menschen zu verstehen, wo und warum einzelne Neuronen aktiviert werden und wie aus diesen eine Prognose entsteht. Die Methode wird vor allem bei der Analyse von Bildklassifikationsalgorithmen angewendet, da zur Vermittlung zwischen Mensch und Maschine Graphiken generiert werden.

Voraussetzung für die Anwendung von Feature Visualization ist ein anwendungsfähiges Neuronales Netzwerk, das schon anhand von Beispielsbildern trainiert wurde und für Prognosen verwendet werden kann.

Für die Feature Visualization wird ein vollkommen fiktives Bild gesucht, das ein bestimmtes Neuron maximal aktiviert. Anders formuliert bedeutet das, dass ein Bild generiert wird, dessen Eigenschaften ein besonders hohes Ergebnis bei der Berechnung der Aktivierungsfunktion eines ausgewählten Neurons erzielen.

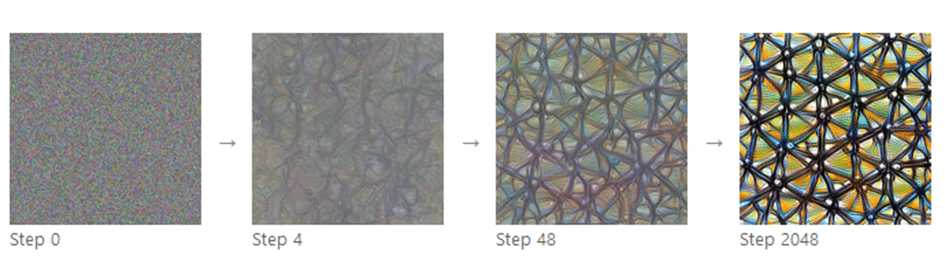

Diese Maximierung wird mittels eines Gradientenverfahrens durchgeführt. Hierbei wird ein Input so lange iterativ verändert, bis eine erneute Überarbeitung zu keiner Erhöhung der Neuronenaktivierung mehr führt. Zuerst wird mit zufälligem Bildrauschen (Step 0 in Abbildung 2) begonnen. Das Bildrauschen wird nun schrittweise auf vollkommen zufälliger Art und Weise verändert, bis sich die Neuronenaktivierung nicht mehr vergrößert. Step 2048 in Abbildung 2 zeigt das optimierte Bild, das eine maximale Aktivierung hervorruft.

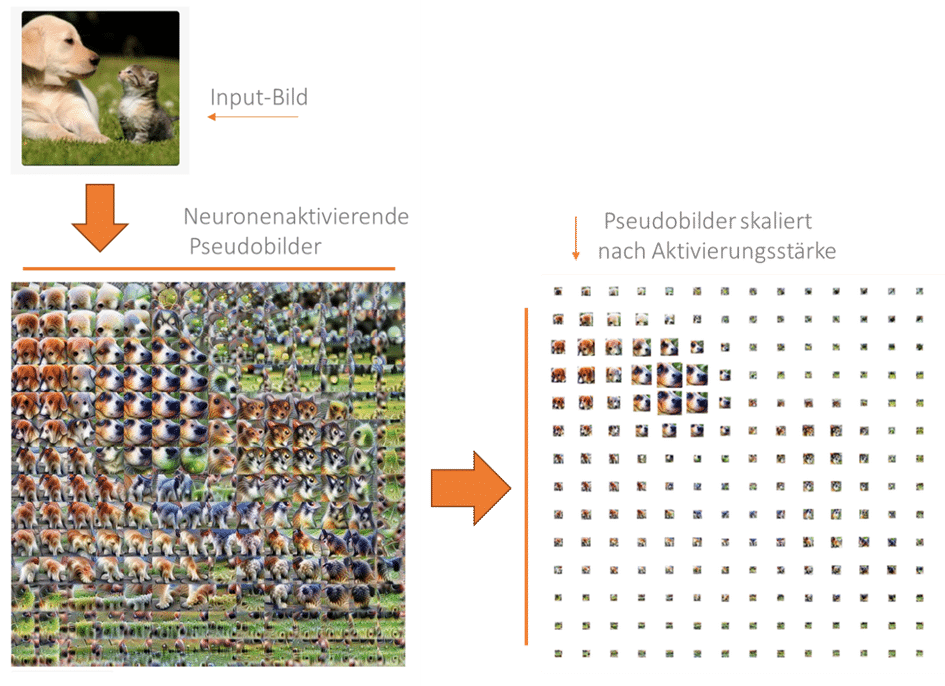

Die Erzeugung mehrerer dieser neuronenaktivierenden Graphiken ermöglicht es, Input-Bilder durch die Linse eines Neuronalen Netzwerkes wahrzunehmen. Daher wird für jedes Neuron das maximal aktivierende Bild gesucht und abgespeichert.

In einem nächsten Schritt wird das zu untersuchende Input-Bild in kleinere Pixelfelder unterteilt und jedes Pixelfeld individuell analysiert. Für jede Bildeinheit werden die aktivierten Neuronen der Aktivierungsstärke nach geordnet und deren optimierte Bilder aggregiert.

Dies möchte ich an einem konkreten Anwendungsfall veranschaulichen.

Abbildung 3 zeigt auf der linken Seite ein von einem Neuronalen Netzwerk bereits als Labrador Retriever gekennzeichnetes Katzen-Hund Bild. Mit Feature Visualization kann nun die Ratio hinter dieser Kategorisierung analysiert werden.

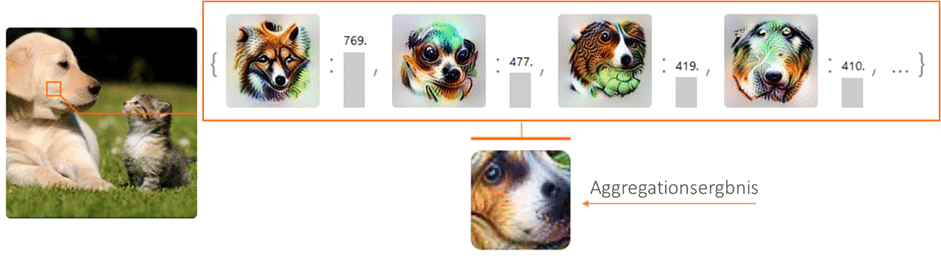

Zuerst wird das Katzen-Hund Bild in mehrere Pixelfelder unterteilt. Beispielhaft für den eingerahmten Abschnitt auf der Wange des Hundes werden in Abbildung 4 die vier optimierten Bilder der vier am stärksten aktivierten Neuronen gezeigt.

Werden die optimierten Bilder nun mit Berücksichtigung der Aktivierungsstärke aggregiert, entsteht ein für das gewählte Pixelfeld repräsentatives Bild – das Aggregationsergebnis.

Wendet man diese Methode an jedem Pixelfeld an, entsteht – wie in Abbildung 3 – ein Gesamtbild aus „Neuronenaktivierenden Pseudobildern“, die verdeutlichen, wie das Neuronale Netzwerk das Input-Bild wahrnimmt. Uns Menschen wird dadurch ermöglicht etwaige Prognosefehler eines Models nachzuvollziehen und im Folgenden das Model anzupassen, um künftig ähnliche Fehler zu vermeiden. Durch die Skalierung der Pixelfelder nach Aktivierungsstärke, können wir außerdem feststellen welche Komponenten des Input-Bildes relevant für die Prognose sind.

Bei unserem Beispielbild ist vor allem der Schnauzenbereich, sowie die Schlappohren des Hundes für die Prognose entscheidend – die Katze wurde dagegen kaum berücksichtigt.

Das Bild wurde daher verständlicherweise als Hund, insbesondere als Labrador Retriever, klassifiziert. (Ich bin zwar keine Hunderassenexpertin, und ich kenne die Unterschiede zwischen Labrador Retriever und Golden Retriever nicht, aber die Klassifikation Hund ist zweifellos richtig!)

Wir sehen also die Blackbox von Artificial Intelligence ist gar nicht so dunkel. Durch innovative Methoden können Artificial Intelligence Prognosen hergeleitet und in Verbindung mit Visualisierungen auch von Laien verstanden werden.

Die Informationen aus diesem Artikel stammen vor allem aus zwei Quellen. Der Artikel Feature Visualization befasst sich genauer mit dem Konzept der Feature Visualization, während The Building Blocks of Interpretability dieses Konzept um andere Methoden erweitert und dadurch eine noch umfassendere Möglichkeit zur Modelinterpretation vorstellt. Beide Artikel enthalten Interaktive Graphiken, die die Konzepte sehr gut verdeutlichen. Ich kann sie Interessierten sehr empfehlen!

Autorin Nora Aurer

Masterstudentin der Volkswirtschaftslehre, interessiert an Datenmanipulation, Data Science sowie ein Fan von kreativen Methoden zur Beweisführung von Kausalität.

Neueste Kommentare