Unsere Welt in 25 Jahren

prognostiziert aus dem Blickwinkel der Naturwissenschaften

Christian Dorninger (gemeinsam mit einer Physik-Abschlussklasse an der HTL-Favoriten)

I. Einleitung

Was kann man in den letzten Physik- oder Chemiestunden einer Oberstufenform tun? Irgendetwas mit Partizipation und Meinungsbildung unter Nutzung des bisher angesammelten Fachwissens: Ja, schon, aber wie aufziehen, damit es spannend ist?

Die Geschichte der Naturwissenschaften hat uns ja gelehrt, dass viele Entdeckungen und Erfindungen Teil des medizinischen oder technischen Grundrepertoieres werden. Röntgenstrahlen oder Halbleiter werden heutzutage selbst verständlich eingesetzt, und wurden natürlich einige Jahre vorher entdeckt bzw. entwickelt. Wie wäre es, sich in der Jetztzeit auf aktuelle naturwissenschaftliche Befunde zu konzentrieren und abzuschätzen, was in zwanzig oder mehr Jahren daraus an Geräten, Verfahren oder Prozessen entstehen wird. Das würde doch gut passen, um ein oder zwei „Zukunftsstunden“ gestalten zu können. Die Schüler*innen wären aufgefordert, ihre Prognosen zu einzelnen Fachgebieten, die uns derzeit äußerst wichtig erscheinen, abzugeben. Ist ja eigentlich erstaunlich, dass ein fundiert naturwissenschaftliches Thema wie der Klimawandel unsere öffentliche Berichterstattung und auch die politische Agenda derart prägen – und dies noch dazu mit Gegenwind der „Schwurbler“, „Ver schwörungs theoretiker“ und „Ignoranten“.

Vorsicht ist schon geboten: Vieles wurde schon gutwillig vorhergesagt und ist nie eingetroffen: Der „sprechschreibene Computer“, die vielen „Lufttaxis“ in den Städten oder Züge mit extrem hoher Geschwindigkeit zwischen diesen Städten. Tolle Unterwasserbehausungen und Weltraumsiedlungen wurden uns vorhergesagt, die internationale Raumstation ISS für Militärs und Wissenschaftler ist hier die einzige Ausbeute, die wir vorweisen können. Der perfekte menschliche Körper, der durch Gentechnik oder bisher ungeahnte Operationstechniken neu entsteht; oder der einfach eingefroren wird, um später wieder erweckt zu werden, sind dann doch eher „Dystopien“ als Utopien.

Aber auch reale Utopien sind gescheitert: Überschall-Passagierflugzeuge sind aus wirtschaftlichen Gründen wieder zurückgenommen worden (letzter Concordeflug Air-France-Flug 4590 im Juli 2000). Auf der anderen Seite ist nach über 60 Jahren hoffnungsvoller Prognosen die künstliche Intelligenz jetzt wirklich so weit, dass von einem „ingenieurmäßigen“ Durchbruch gesprochen werden kann. Man muss einfach aufpassen – nichts ist so schwer vorherzusagen wie zukünftige Entwicklungen.

Trotzdem ist es reizvoll, über eine derartige Diskussionsschiene Entwicklungen ans Licht zu bringen, von denen wenige Leute wirklich etwas wissen. Die unheimliche Quantenwelt beispielsweise oder Messverfahren im Attosekundenbereich, nur um zwei Nobelpreisarbeiten mit österreichischer Beteiligung aufzuzählen. Wir widmen uns hier exemplarisch den Themenbereichen „Umweltkatastrophen und Klimawandel“, „Energietechnik und Kernfusion“, „Digitalisierung und Quantentechnologien“, „Medizintechnik und Nanowelten“, „Werkstoffe der Zukunft“ sowie „Weltraumtechnik und Besiedelung von anderen Planeten“.

II. Umweltkatastrophen und Klimawandel

II.1 Zweifellos ist der Klimawandel, der laufend Umweltkatastrophen verursacht, das am meisten herausfordernde aktuelle Problem, das die Menschheit die nächsten Jahre und Jahrzehnte beschäftigen wird. Naturwissenschaftliche Fakten dazu seinen kurz erwähnt:

Der Intergovernmental Panel on Climate Change (IPCC, zwischenstaatlicher Ausschuss für Klimaänderungen), im Deutschen oft als Weltklimarat bezeichnet, wurde im November 1988 vom Umweltprogramm der Vereinten Nationen (UNEP) und der Weltorganisation für Meteorologie (WMO) als zwischenstaatliche Institution ins Leben gerufen. Hauptaufgabe des Ausschusses ist es, die naturwissenschaftlichen Grundlagen und den weltweiten Forschungsstand über die Auswirkungen der globalen Erwärmung und seine Risiken sowie Minderungs- und Anpassungsstrategien zusammenzutragen und aus wissenschaftlicher Sicht zu bewerten. Dazu beruft der IPCC tausende Wissenschaftler aus aller Welt. Diese erstellen die Sachstandsberichte des IPCC. Bisher hat der IPCC fünf Sachstandsberichte und mehr als zehn Sonderberichte sowie Richtlinien für die Erstellung von Treibhausgasinventaren veröffentlicht.

Die IPCC–Berichte gelten als „Gold standard“ der Klimaforschung. Sie werden innerhalb der Wissenschaft als glaubwürdigste und fundierteste Darstellung bezüglich des naturwissenschaftlichen, technischen und sozioökonomischen Forschungsstandes über das Klima und seine Veränderungen sowie über Möglichkeiten des Umgangs damit betrachtet. Die Schlussfolgerungen des IPCC werden von allen großen US-amerikanischen wissenschaftlichen Gesellschaften mit einschlägiger fachlicher Kompetenz bestätigt, unter anderem von der American Geophysical Union, der American Meteorological Society und der American Association for the Advancement of Science. Zudem werden sie u. a. von den nationalen Akademien der Wissenschaften vieler Staaten wie Frankreich, Russland, Deutschland, Japan, Italien, Kanada, China und Brasilien sowie der Royal Society bekräftigt. Der IPCC wurde 2007, gemeinsam mit dem ehemaligen US-Vizepräsidenten Al Gore, mit dem Friedensnobelpreis ausgezeichnet.

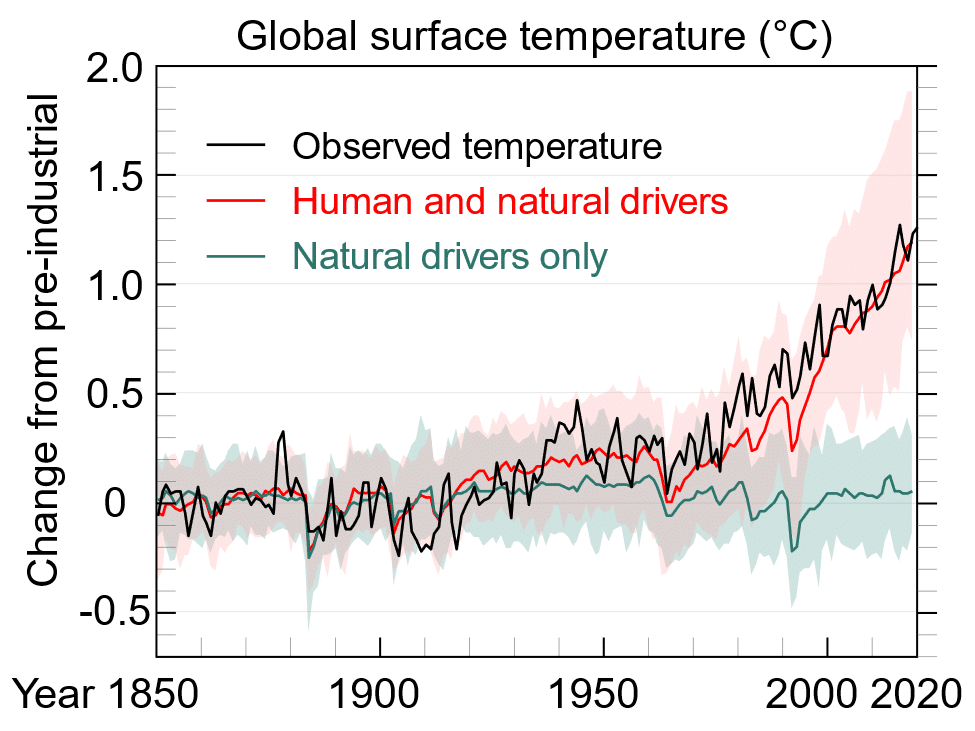

Der Sechste Sachstandsbericht (englisch Sixth Assessment Report, AR6; auch Sechster Weltklimabericht 2020/21) ist eine systematische Übersichtsarbeit zum Forschungsstand der Klimaforschung. In einem wesentlichen Diagramm sieht man, wie deutlich die vom Menschen verursachten „Triebkräfte“ (CO2-Ausstoß und weitere) die Oberflächentemperatur der Erde erhöhen.

II.2. Die Kernaussagen des Berichts sind folgende:

A. Gegenwärtiger Zustand des Klimas

A.1 Es ist unbestritten, dass der Mensch die Atmosphäre, die Ozeane und das Land erwärmt hat. Weitreichende und schnelle Veränderungen in der Atmosphäre, den Ozeanen, der Kryosphäre und der Biosphäre sind eingetreten

A.2 Das Ausmaß der jüngsten Veränderungen im Klimasystem als Ganzes und der gegenwärtige Zustand vieler Aspekte des Klimasystems sind beispiellos über viele Jahrhunderte bis Tausende von Jahren

A.3 Der vom Menschen verursachte Klimawandel wirkt sich bereits auf viele Wetter- und Klimaextreme in allen Regionen der Erde aus. Belege für beobachtete Veränderungen bei Extremen wie Hitzewellen, Starkniederschlägen, Dürren und tropischen Wirbelstürmen und insbesondere deren seit dem Fünften Bewertungsbericht (AR5) haben sich die Hinweise auf den menschlichen Einfluss verstärkt.

A.4 Verbesserte Kenntnisse über Klimaprozesse und die Reaktion des Klimasystems auf einen zunehmenden Strahlungsantrieb führen zu einer besten Schätzung der Gleichgewichts-Klimasensitivität von 3°C.

Der Anstieg der globalen Temperaturen ist menschgemacht, die Natur allein würde die blaue Kurve erzeugen.

B. Mögliche Klimazukünfte

B.1 Die globale Oberflächentemperatur wird bei allen betrachteten Emissionsszenarien mindestens bis zur Mitte des Jahrhunderts weiter ansteigen. Die globale Erwärmung von 1,5°C und 2°C wird im Laufe des 21. Jahrhunderts überschritten werden, wenn nicht in den kommenden Jahrzehnten die Emissionen von Kohlenstoffdioxid (CO2) und anderen Treibhausgasen stark reduziert werden.

B.2 Viele Veränderungen im Klimasystem werden in direktem Zusammenhang mit der zunehmenden globalen Erwärmung größer. Dazu gehören die Zunahme der Häufigkeit und Intensität von Hitzeextremen, marinen Hitzewellen und Starkniederschlägen, landwirtschaftlichen und ökologischen Dürren in einigen Regionen, und der Anteil intensiver tropischer Wirbelstürme sowie der Rückgang des arktischen Meereises, der Schneedecke und ständig gefrorener Böde.

B.3 Die fortgesetzte globale Erwärmung wird voraussichtlich den globalen Wasserkreislauf weiter verstärken, einschließlich seiner Variabilität, der globalen Monsun-Niederschläge und der Schwere von Regen- und Trockenperioden.

B.4 In Szenarien mit steigenden CO2-Emissionen werden die Kohlenstoffsenken im Meer und an Land weniger wirksam sein, um die Anreicherung von CO2 in der Atmosphäre zu verlangsamen.

B.5 Viele Veränderungen, die auf vergangene und künftige Treibhausgasemissionen zurückzuführen sind, sind für Jahrhunderte bis Jahrtausende unumkehrbar. Jahrhunderte bis Jahrtausende unumkehrbar, insbesondere Veränderungen der Ozeane, der Eisschilde und des globalen Meeresspiegels.

C. Klimainformationen für Risikobewertung und regionale Anpassung

C.1 Bei einer weiteren globalen Erwärmung wird jede Region den Projektionen zufolge zunehmend mit gleichzeitigen und mehrfachen Veränderungen der klimatischen Einflussfaktoren konfrontiert sein. Veränderungen bei mehreren klimatischen Einflussfaktoren wären bei 2°C im Vergleich zu 1,5°C globaler Erwärmung weiter verbreitet und bei höheren Erwärmungsgraden noch weiter verbreitet und/oder ausgeprägter.

C.2 Wenig wahrscheinliche Folgen wie der Zusammenbruch von Eisschilden, abrupte Änderungen der Ozeanzirkulation, einige zusammengesetzte Extremereignisse und eine Erwärmung, die deutlich größer ist als die sehr wahrscheinliche Bandbreite der künftigen Erwärmung, können nicht ausgeschlossen werden und sind Teil der Risikobewertung.

II.3 Soweit die für naturwissenschaftlich Denkende klaren Befunde. Im geopolitischen Prozess stellt sich immer wieder die Frage, warum klare Maßnahmen zur Vermeidung dieser Klimazukünfte nicht energisch genug getroffen werden. Das hat mit unterschiedlichen Interessen und vordergründigen kurzfristigen Vorteilen des derzeitigen Weges zu tun: Eine gemeinsame „Weltpolitik“ in diesen Fragen gibt es nicht, und er ist durch die unterschiedlichen Entwicklungsgrade der Regionen der Erde auch nicht herstellbar. Bleibt die Frage, ob es „technische Innovationen“ gibt, die mithelfen können, den Temperaturanstieg der Erde zu mildern (mehr wird nicht möglich sein).

II.3.1. Künstliche Aerosole – auf einen großen Vulkanausbruch vertrauen

Eine Idee ist es, einen Vulkanausbruch „nachzuahmen“; entstand nach dem Ausbruch des Vulkans Pinatubo auf den Philippinen 1991. Damals gelangten Schwefelpartikel in die Stratosphäre, reflektierten die Sonnenstrahlung und sorgten dafür, dass die Durchschnittstemperatur auf der Erde kurzzeitig um ein halbes Grad sank. Berechnungen legen nahe, dass die Erdbevölkerung jährlich fünf bis achtmal so viel Aerosole in die Stratosphäre bringen müssten als nach dem Ausbruch des Vulkans Pinatubo. Um jährlich ein einziges Grad Celsius zu senken, bräuchten wir täglich mindestens 7.000 Flüge mit Spezialflugzeugen, die die Partikel in der Stratosphäre versprühen. Und dann stellt sich noch die Frage, woher wir die Schwefelpartikel nehmen: Dafür müssten wir wohl andere Ressourcen verbrauchen. Wegen der vielen Risiken rät der Weltklimarat in seinen aktuellen Berichten von Solar Radiation Management ab. Die künstlichen Aerosole wären nicht nur ein immenser Eingriff in die Natur mit Risiken für den ganzen Planeten, sondern hätten auch gesellschaftliche Konsequenzen: Es gäbe keinen blauen Himmel mehr. Dadurch hätten vermutlich mehr Menschen Depressionen.“

II.3.2. CO2– Capturing – CSS-Verfahren

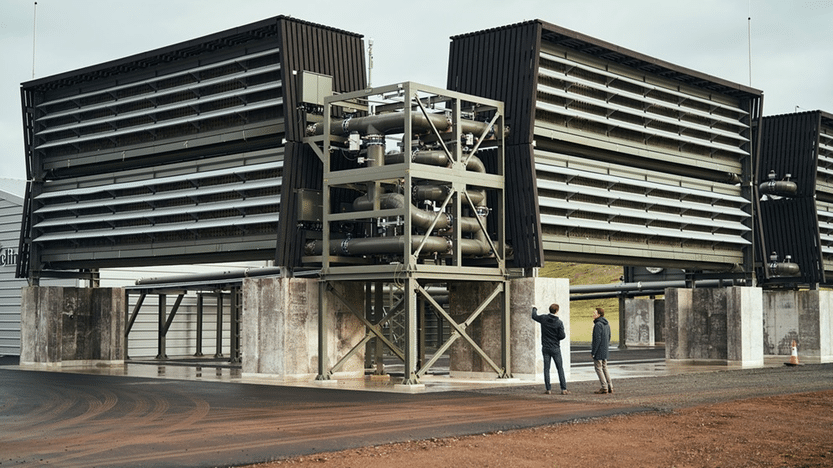

Nach Berechnungen des Weltklimarats wird die Erdbevölkerung das 2-Grad-Ziel wohl nur noch mit „negativen Emissionen“ erreichen können. Die Idee dahinter: CO2 soll wieder aus der Luft geholt werden. Auch für unsere „Restemissionen“ werden sie demnach unvermeidlich sein. Dabei handelt es sich um Bereiche, die wohl unvermeidlich nach wie vor Treibhausgase ausstoßen werden – auch wenn wir unsere Klimaziele erreicht haben. Dazu werden wohl die Landwirtschaft oder die Industrie zur Herstellung von Beton und Zement zählen. Forschende gehen davon aus, dass diese Bereiche auch dann noch etwa eine Menge an Treibhausgasen emittieren werden, die mit 10 bis 15 Prozent der heutigen Emissionen vergleichbar sind.

Wissenschaftler versuchen schon jetzt mit Maschinen CO2 aus der Luft zu filtern oder direkt an Kohlekraftwerken zu entnehmen. Unterirdische Lager in der Erde oder am Meeresboden müssten das CO2 im Anschluss lange und sicher lagern können. In Norwegen wird bereits flüssiges CO2 in ehemalige Erdgas- und Erdöllagerstätten in die Erde oder in den Meeresgrund gepresst. Ob das CO2 dann dauerhaft gespeichert wird, ist nicht unbedingt klar. Die Projekte erwiesen sich bisher als relativ sicher. Ein Problem dieser Methoden: Die riesigen Maschinen, die das C02 filtern, haben bisher selbst einen immensen Energieverbrauch – und wir würden sehr viele von ihnen brauchen. Um einen Effekt auf die Erderwärmung zu haben, müssten sie mit erneuerbaren Energien betrieben werden. Eine andere Idee ist, die Energie zu nutzen, die bei der Müllverbrennung entsteht, um die Maschinen zum Laufen zu bringen.

II.3.3 Künstliche Verwitterung

Das Prinzip der Verwitterung nachahmen. In der Natur entfernen verschiedene Gesteinsarten in Kombination mit Wasser CO2 aus der Atmosphäre und binden es dauerhaft. Man nutzt diesen Effekt schon jetzt, um saure Böden zu bearbeiten und Felder zu düngen. Gleichzeitig macht Kalk oder Basaltgestein den Boden fruchtbarer. Künftig kann man Gestein auf Felder und in Ozeane streuen. Eine Studie von der Universität Augsburg kam sogar zu dem Ergebnis, dass der klimaschützende Effekt in natürlichen Ökosystemen mit nährstoffarmen Böden noch stärker ist als auf Feldern. In diese Ökosysteme einzugreifen, wäre jedoch riskant: Der Boden kann mit Schwermetallen belastet werden, aber es kann auch zu uns noch völlig unbekannten Nebeneffekten kommen. Außerdem wäre der Aufwand immens: Man braucht sehr viel Gestein – global gesehen jedes Jahr die Größenordnung eines Berges, den man kleinraspeln müsste. Auch das Gestein zu verteilen, würde eine Kraftanstrengung bedeuten. Eine Option jedoch ist, die Infrastruktur der Kohleindustrie zu nutzen.

II.3.4. Gigantische Aufforstung

In der Natur wird CO2 aufgenommen, gespeichert und umgewandelt – nur dauert das teilweise lange. Deshalb gibt es die Idee, natürliche Prozesse künstlich zu beschleunigen und nachzuahmen. Zum Beispiel, indem man Wälder ausdehnt. Eine weitere Möglichkeit ist, schnellwachsende Pflanzen wie Elefantengras auf Biomasseplantagen anzubauen. Verbrennt man diese Biomasse, könnte man die dabei gewonnene Energie anstatt fossiler Brennstoffe verwenden. Das CO2 könnten wir dabei abzweigen. Dann müssten wir es sicher im Boden speichern.

In Szenarien, die die globale Erwärmung auf 1, 5 Grad begrenzen, bräuchte man nach Berechnungen bis 2050 weltweit rund 300 Millionen Hektar zusätzlichen Wald und 200 Millionen Hektar Ackerland für Bioenergie. Das entspricht ungefähr der Größe von Indien beziehungsweise Mexiko. Viele Forscher gehen sogar von einer benötigten Fläche aus, die fünfzig mal so groß wie Deutschland sein müsste – nur um unsere weltweiten Restemissionen zu tilgen.

Eine der größten Hürden dabei ist, dass wir die meisten Flächen für die Landwirtschaft nutzen. Daher werden immer wieder Vorschläge laut, Wüsten und Steppen, die sich weltweit stärker ausbreiten, zu nutzen. Die Idee, eine „Great Green Wall“, einen Grünstreifen in der Sahara zu pflanzen, kam bereits im vergangenen Jahrhundert auf. Auch dann würden wir jedoch Ökosysteme und Wasserkreisläufe verändern. Forsten wir in den oft hellen Wüsten auf, könnte es auf der Erde sogar wärmer werden. Die Farbe der Erde würde sich verändern und das Sonnenlicht nicht mehr so stark reflektieren.

Die Liste von möglichen Maßnahmen ließe sich fortsetzen. Nun kann man darüber diskutieren, welche ethischen Bedenken es für derart weitreichende Maßnahmen gäbe und welche gesellschaftlichen und wirtschaftlichen Auswirkungen derartige Eingriffe in die Natur hätten. Läuft „Geoengineering“, wie der Fachbegriff heißt, nur darauf hinaus, CO2– Sparmaßnahmen zu stoppen und bei Aussetzen des Geoengineering eine umso größere Temperarturerhöhung zu riskieren? Mit diesen Fragen müssen sich zukünftige Ingenieure auseinandersetzen! Soweit zur ersten „Zukunft“!

III. Energietechnik und Kernfusion

Bei krisenhaften Entwicklungen und Kriegen ist die Energieversorgung immer ein großes Thema. Seit der Klimawandel auch eine „Energiewende“ bedingt, umso mehr. Übrigens: Für Naturwissenschaftler*innen wird Energie nie „erzeugt“, sondern immer nur von einer nicht so praktikablen Form (fossiles Gas, Öl, Uran oder Kohle, „höher“ liegendes Wasser im Stausee) in eine praktikable (elektrische Energie, Bewegungsenergie, Wärmeenergie) umgewandelt. Das hat jetzt mit der Energiewende wenig zu tun; sie lautet ja:

Raus aus Kohle, Gas, Öl und Kernenergie (letzteres für manche Ländern nur bedingt), hinein in die Erzeugung regenerativer Energiequellen wie Wasserkraft (Flusskraftwerke, (Pump)speicher kraft werke, Gezeitenkraftwerke etc.), Solarenergie (photovoltaisch oder solarthermisch), Windenergie, Geothermie oder Energie aus Biogasen. Bei der Wärmeaufbereitung soll der Wärmepumpe gegenüber der Verbrennung der Vorzug geben werden. Lokal erzeugte Energie, die direkt genutzt wird (Solarstrom vom Dach im Haushalt) sollte der (meist elektrischen) Energie in großen zentralen Kraftwerken der Vorzug gegeben werden. Gebäude sollten so gebaut werden, dass sie die Wärme (bzw. Kälte) bereits passiv durch ihre Konstruktion oder bauphysikalisch speichern. Durch Bepflanzung in Städten sollen im Sommer „Hitzeinseln“ vermieden werden. Durch eine ausgefeilte Regelungstechnik sollen die Energiemedien effizient eingesetzt werden. Effiziente neue Speichermedien wie „grüner Wasserstoff“ wären zu finden.

Wozu das alles? Um den CO2 – Ausstoß einzuschränken bzw. auch teure Energie einzusparen. Eine ökologische Lebensweise macht die Erde besser bewohnbar und verringert Emissionen und Abfall. Das eine derartige Lebensweise mit persönlichen Einschränkungen verbunden ist und auch manchmal umständlich und nicht so komfortabel ist, erzeugt gesellschaftliche Spannungsfelder und politische Auseinandersetzungen.

Physiker*innen haben jetzt noch einen Einwurf: Möglicherweise ist eine Kasteiung mit vorübergehendem Energiesparen nur einige Jahre notwendig, weil uns in Zukunft eine unerschöpfliche Energiequelle bevorsteht. Die Kernfusion. Alles paletti also?

Forschenden aus den USA ist es gelungen, mehr Energie aus einer Kernfusion herauszuholen, als sie reinstecken mussten. Eine Sensation! Doch ist das Experiment wirklich der große Durchbruch? Fünf Antworten auf die wichtigsten Fragen

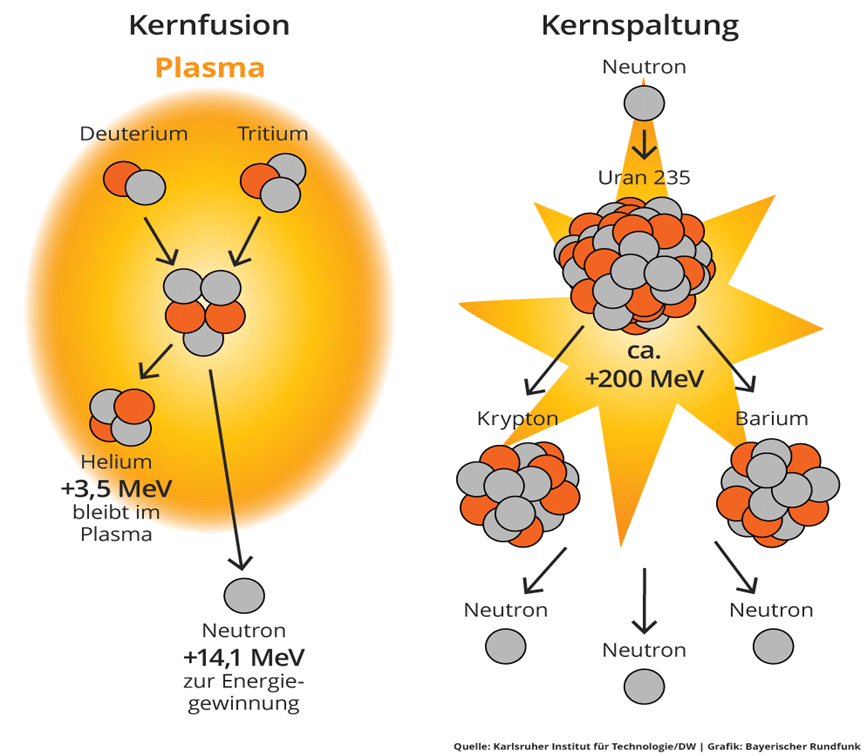

Wie funktioniert eine Kernfusion?

Um aus einer Kernfusion Energie zu gewinnen, braucht es dieselbe Grundlage, die auch die Kernspaltung so attraktiv macht: Atomkerne. Bei Fusionen, die auf der Erde herbeigeführt werden, nutzen Forscherinnen und Forscher die Wasserstoffisotope Deuterium und Tritium. Ersteres kommt in Wasser vor und ist damit in riesigen Mengen verfügbar. Tritium kann aus Lithium gewonnen werden. Verschmelzen nun die beiden Ausgangsstoffe Deuterium und Tritium zu einem Heliumkern – genauer: einem Alphateilchen und einem Neutron –, wird Energie freigesetzt.

Bei einer Kernfusion entsteht zwar auch radioaktiver Müll, aber wesentlich weniger als bei der Kernspaltung, zudem ist die Zerfallszeit kürzer. Auch besteht keine Gefahr einer unkontrollierten Kettenreaktion, die in einem Gau mündet. Wenn die Kernfusion außer Kontrolle gerät, erlischt sie von selbst – einer der Gründe, warum es so schwer ist, sie überhaupt in Gang zu setzen.

Warum weckt die Methode solch große Hoffnungen?

Die Kernfusion gilt als letzte primäre Energiequelle, die die Menschheit noch nicht für sich nutzt. Dabei ist das Potenzial gewaltig, denn der Prozess ist im Vergleich zu anderen um ein Vielfaches effizienter. „In unserem Institut steht immer ein Tablett mit Wasserflaschen und zwei lithiumhaltigen Steinen“, erzählt Direktor Linsmeier am Institut für Energie- und Klimaforschung in Jülich. „Der darin steckende Energiegehalt an Deuterium und Lithium reicht, um eine durchschnittliche Familie das ganze Jahr zu versorgen.“

Außerdem werden bei der Kernfusion keine Treibhausgase freigesetzt, die die Erwärmung der Erdatmosphäre weiter anheizen. Der Mix aus schier unendlicher Verfügbarkeit, vergleichsweise sehr geringen Treibhausgasemissionen und ausbleibenden radioaktiven Abfällen macht die Kernfusion neben den Solar- und Windenergiequellen zu einem der Hoffnungsträger für die Energiegewinnung der Zukunft.

Woran hapert es?

Dass zwei Wasserstoffatomkerne zu einem Heliumatomkern fusionieren und Energie freigesetzt wird, passiert ständig. Allerdings geschieht dies nicht auf der Erde und nicht unter kontrollieren Bedingungen, sondern im Innern der Sonne. Dort ist die Temperatur hoch genug, um den Prozess der Kernfusion dauerhaft aufrecht zu erhalten.

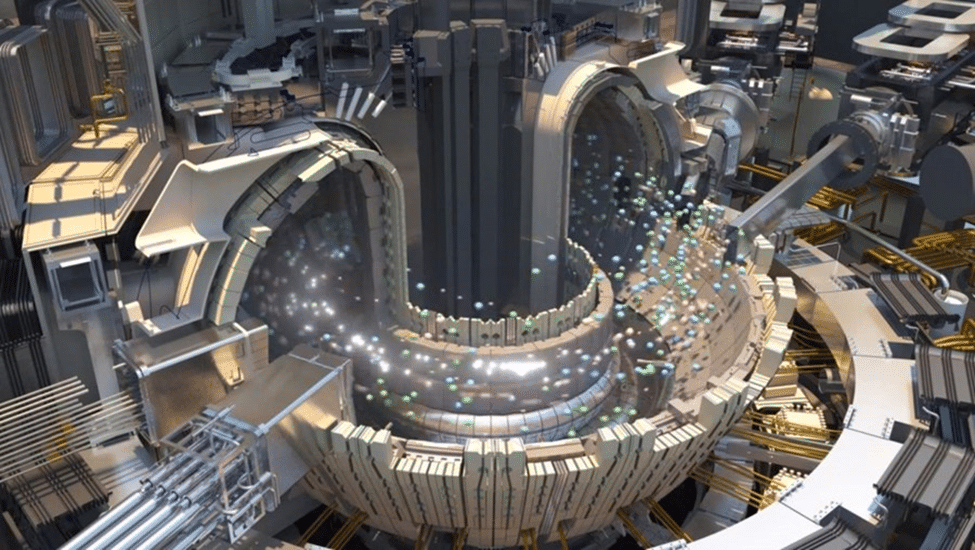

Daran scheitern die irdischen Versuche bislang allerdings. Im Grunde gebe es zwei Möglichkeiten, um Deuterium und Tritium miteinander zu verschmelzen, erläutert Linsmeier. Entweder man heize sie durch leistungsstarke Laser so schnell und heiß auf, dass die beiden Isotope, die sich normalerweise abstoßen würden, nicht schnell genug voneinander entfernen können und dank der Hitze fusionieren. Dieser Ansatz wurde im aktuell diskutierten Experiment der US-Forscherinnen und Forscher verfolgt. Oder man verwende ein bis zu 150 Millionen Grad Celsius heißes Plasma, das die Atomkerne in eine ausreichend hohe Geschwindigkeit versetzt, sodass deren Abstoßung überwunden und die Fusion eingeläutet wird. „Diese Bedingungen herzustellen ist jedoch unglaublich schwierig und wenn irgendetwas schief geht, fällt die Reaktion sofort in sich zusammen“, sagt Linsmeier. „Im Gegensatz zur Kernspaltung ist die Fusion keine Kettenreaktion, ihre Bedingungen müssen dauerhaft und sehr aufwendig künstlich aufrechterhalten werden. Darin liegt bislang die große Schwierigkeit.“

Warum wird das Experiment der Forschenden aus den USA als ein so großer Erfolg gehandelt?

Am 5. Dezember 2022 ist es einem Forschungsteam am Lawrence Livermore National Laboratory in Kalifornien gelungen, eine Kernfusion auszulösen, bei der mehr Energie gewonnen als verbraucht wurde – so zumindest die Sensationsmeldung, die seit Montagabend um die Welt geht. Die US-Energieministerin Jennifer Granholm sprach sogar von der „beeindruckendsten wissenschaftlichen Leistung des 21. Jahrhunderts“ und dem Beginn einer neuen Ära der Energiegewinnung.

Die Forscherinnen und Forscher nutzten 192 Hochleistungslaser, um wenige Milligramm gefrorenen Wasserstoff so stark zu erhitzen, dass der Fusionsprozess ausgelöst wurde. Dass dies prinzipiell möglich ist, war schon länger klar, Nachrichtenwert hatte jedoch die Energiebilanz des Experiments: 2,1 Megajoule waren nötig, um die Fusion auszulösen, frei wurden 3,2 Megajoule. „Das zeigt, dass es den Kollegen gelungen ist, zum ersten Mal eine Fusionsreaktionen auszulösen, die sich selbst erhalten hat“, sagt Linsmeier. „Die aus der ersten Fusionsreaktion gelieferte Energie wurde genutzt, um weitere Fusionen auszulösen, ohne dass der Laser weiter darauf schießen musste. Die Fusionsreaktion hat sozusagen gebrannt – und das ist tatsächlich ein großer Erfolg.“

Der Haken? Bezieht man den gesamten Versuchsaufbau in die Rechnungen mit ein, ist die Energiebilanz negativ, und zwar deutlich. Insgesamt verbrauchten die Laser, die nicht direkt auf den Wasserstoff gerichtet, sondern zunächst in Röntgenstrahlung umgewandelt wurden, 300 Megajoule Strom. „Um also wirklich Energie zu gewinnen, müssten die Laser um ein Vielfaches effizienter werden“, sagt Linsmeier. Eine solche technologische Entwicklung sei jedoch derzeit nicht absehbar. Außerdem müsste dieser Prozess nicht nur einmalig passieren, sondern sich zuverlässig viele Male pro Sekunde wiederholen. Auch das gelang im US-Experiment noch nicht.

Welcher Zeithorizont für ein kommerziell funktionierendes Kernfusionskraftwerk ist realistisch?

Seit den 1950er-Jahren suchen Forscherinnen und Forscher nach einer Möglichkeit, den Fusionsprozess der Sonne auf der Erde im großen Stil zu replizieren. Seit 2007 baut ein Forschungsteam im südfranzösischen Kernforschungszentrum den Versuchs-Kernfusionsreaktor ITER (International Thermonuclear Experimental Reactor). Im Gegensatz zum kalifornischen Experiment setzt das ITER-Projekt auf diejenige Methode, die ohne Laser auskommen möchte: Ausreichend heißes Plasma soll so eingeschlossen werden, dass es nicht abkühlt und die Fusionsreaktion dauerhaft ablaufen kann. Läuft alles nach Plan, soll ITER im Jahr 2025 fertig gestellt werden und dann die ideale Bauweise eines kommerziellen Kernfusionsreaktors ermitteln. Wie lange das dauert, ist schwer abzuschätzen. Linsmeier gibt sich jedoch zuversichtlich: Stelle die Politik ausreichen finanzielle Mittel zur Verfügung, könne man bereits in 15 Jahren einen ersten Kernfusionsreaktor zu Demonstrationszwecken ans Netz bringen.

Wie lange es dann dauern wird, bis die Kernfusion in Reaktoren nutzbringend industriell einsetzbar ist, steht noch in den Sternen. Fachleute sehen eine praktische Anwendung in eben 15 bis 20 Jahren. Bis dorthin müsse man mit den derzeitigen Technologien auskommen. Daher stellt sich die Frage derzeit nicht, welchen Weg man einschlägt: Die Energiegewinnung aus Wasser, Sonne und Wind hat derzeit noch keine Alternative. Möglicherweise braucht man dann die Energie aus fusionierten Atomkernen nicht mehr…

IV. Quantentechnologien und Digitalisierung

Quantentechnologie ist ein interdisziplinäres Feld auf dem die ingenieurwissenschaftliche Nutzbarmachung von Quanteneigenschaften im Mittelpunkt steht. Solche Quanteneigenschaften können etwa diskrete Energieniveaus, Zustandsüberlagerung oder Quantenverschränkung sein. Eine Orientierung über die Teilgebiete bietet die Einteilung in Quantencomputing, Quantenkommunikation, Quantenmesstechnik und Basistechnologien für Quantensysteme.

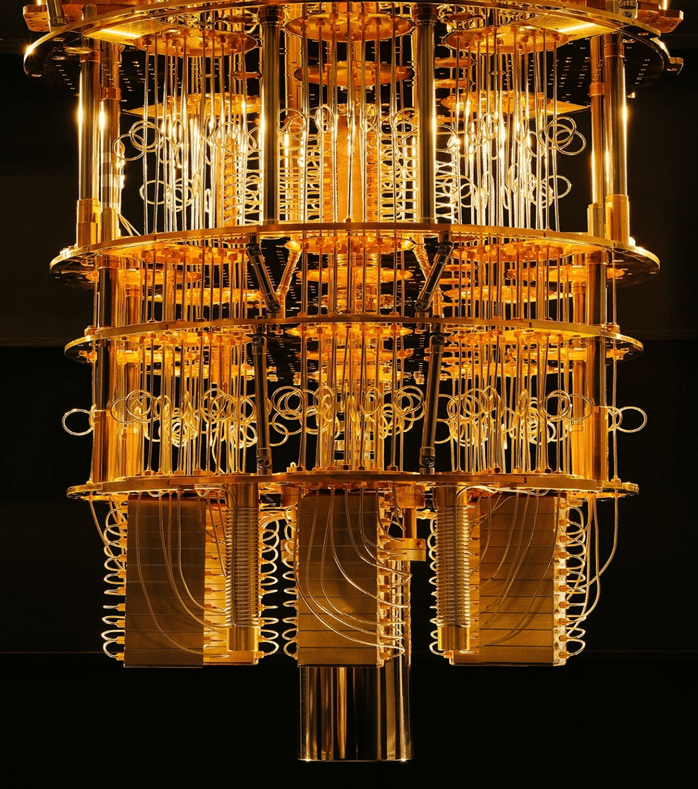

Quantencomputer sind Maschinen, die statt mit herkömmlichen Bits (die den Wert 0 oder 1 annehmen können) mit „Quantenbits“ oder „Qubits“ arbeiten (die einen Überlagerungszustand von 0 oder 1 annehmen können). Aus der quantenmechanischen Überlagerung folgt zumindest aus theoretischer Sicht eine deutliche Beschleunigung der Rechenleistung, die eine Vielzahl heute gebräuchlicher Verfahren beschleunigt, wie etwa Datenbanksuche, Navigation oder Primzahlzerlegung. Weiterhin wird von Quantencomputern erwartet, dass sie eine Reihe neuartiger Anwendungen im Computerbereich beschleunigen, wie bestimmte Optimierungen und Maschinenlernen.

Analysten von Morgan Stanley prognostizieren, dass sich der Markt für High-End-Quantencomputer bis 2025 auf zehn Milliarden Dollar pro Jahr verdoppeln wird. Neben IBM und Google bauen auch der chinesische Internetriese Alibaba und Start-ups wie Novarion, Rigetti oder D-Wave an den Superrechnern.

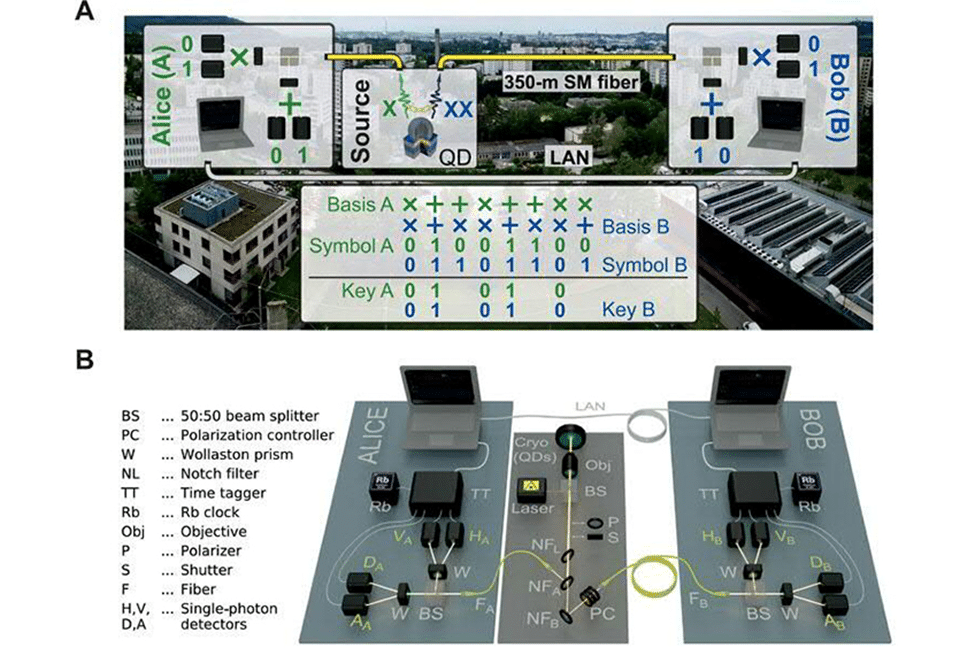

Quantenkommunikation ist eine verschlüsselte Kommunikation, die auf dem Prinzip, dass das Entschlüsseln ohne Kenntnis des Schlüssels verhältnismäßig hohe Rechen-kapazitäten benötigt, beruht. Da aber Rechenkapazitäten stetig wachsen, wird eine sichere Verschlüsselung immer aufwändiger. Quantenkryptographie ist hier ein Ausweg, da sie auf dem fundamentalen Prinzip beruht, dass Quanteninformationen nicht einfach dupliziert werden können („No-Cloning Theorem“). Eine wesentliche Komponente der Kommunikation ist der Quantenschlüsselaustausch (Quantum Key Distribution): Es ist ein Verfahren, Schlüssel in einer Art und Weise mit verschränkten Lichtquanten zu übertragen, die jedweden Eingriff in die Übertragung, etwa durch einen Lauscher im Kommunikationskanal, für den Benutzer sichtbar macht.

Um auf das Thema Digitalisierung zurückzukommen, ist in den vergangenen Jahrzehnten seit 1980 die zunehmende Miniaturisierung der Halbleiterchips (Moorsches Gesetz), aber auch die rasche Zunahme der Datenverarbeitungs-Geschwindigkeiten zu beobachten. Trotzdem ist man weit weg vom großen Sprung bei diesen Geschwindigkeiten. Eine Verschlüsselung durch Primzahlenzerlegung wird noch Jahrzehnte halten, mögen konventionelle Computer noch so schnell werden. Es ist immerhin bemerkenswert, dass die Gefahr, die Schlüssel mit Rechnerkapazität zu knacken, durch eine neue Technologie verunmöglicht wird: Die Quantenkryptographie mit verschränkten Photonen. Die obige kleine Anordnung mit Alice und Bob kann nun bald industriell genutzt werden- wohl eine der kurzfristigsten „Utopien“, wie man in diesem Aufsatz im Programm hat. Die Quantenverschränkung lässt eine Kommunikation mit hoher Reichweite zu, sodass diese Technologie auch über Satelliten weltweit erfolgen kann.

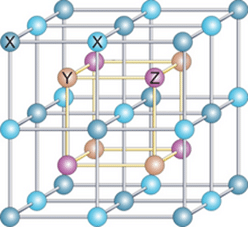

Trotzdem schauen alle auf „Quanten computing“: Die Vorarbeiten mit unterschiedlichen Technologien (Ionenfallen, supraleitende Qubits, Quantencomputer realisiert mit Kernspins in Molekülen, Quantencomputer auf Basis von Stickstoff-Fehlstellen-Zentren in Diamant, Quantencomputer auf Basis optischer Gitter neutraler kalter Atome, Quantencomputer mit Elektronenspins in Quantenpunkten von Halbleitern.) erweisen sich als mühsam, der Durchbruch dieser Technologien scheint nicht einfach zu sein. Die Auswirkungen allerdings lassen sich vorhersagen: Extreme Erhöhung der Rechengeschwindigkeit durch „naturgegebene“ Parallelprozesse (Quantensuperposition), eine Anpassung an einzelne Problemstellungen (recht unterschiedliche Quantencomputer für unterschiedliche Problemfälle) und derzeit noch eine hohe Fehleranfälligkeit, an deren Reduktion gearbeitet werden muss. Die erfolgten Vorteile – und hier gibt es kaum Nachteile – würden viele neue Anwendungen erlauben, unter anderem Anwendungen zur künstlichen Intelligenz, die im Lernprozess von neuronalen Netzen von der hohen Berechnungskapazität leben. Ohne auf Details einzugehen, die jetzt begonnene „Revolution“ des Einsatzes künstlicher Intelligenz wird sich in den folgenden Jahren kontinuierlich erweitern. Mit dem Einsatz von Quantentechnologien bekäme sie nochmals einen „Schub“. Auch hier muss man wieder über ethische Fragen, aber auch über die Risken eines Einsatzes sprechen. Es ist kein Zufall, dass in den letzten Jahren bedeutende Wissenschaftler*innen vor einem zu intensiven Einsatz von KI-Systemen warnen…

V. Medizintechniken und Nanowelten

Der Nobelpreis für Physik 2023 ging unter anderen an Ferenc Krausz, der mit ultraschnellen Laserblitzen in die Atto-Sekundenwelt vorstieß (1 Attosekunde = 10-18 Sekunden). Er vermass damit nicht die Größe eines Atoms – dies war schon vor Jahren durch die Rastertunnelmikroskopie gelungen – sondern die Zeit, die Bewegungsvorgänge in einem Atom brauchen. In einigen Attosekunden durchmisst Licht ein Atom. Als eine Anwendung nennt Krausz die Entwicklung eines Bluttests, der Krebserkrankungen frühzeitig entdeckt. Die Vision dahinter wird von vielen Wissenschaftlern geteilt. Während heute Menschen zumeist erst Symptome entwickeln und dann zum Arzt gehen, sollen zukünftig regelmäßige Checks und Tests dafür sorgen, dass Krankheiten früher erkannt werden. Dadurch wiederum erhöhen sich dann auch die Chancen auf eine erfolgreiche Behandlung.

Die Medizin im 21. Jahrhundert wird sich so schnell verändern wie nie zuvor – und mit ihr das Gesundheitswesen. Bahnbrechende Entwicklungen in Forschung und Digitalisierung werden die Auswertung und Nutzung riesiger Datenmengen in kurzer Zeit ermöglichen. Das wird unsere Kenntnisse über Gesundheit und gesund sein sowie über die Entstehung, Prävention und Heilung von Krankheiten vollkommen verändern. Gleichzeitig wird sich die Art und Weise, wie Medizin praktiziert wird, fundamental verändern. Das Selbstverständnis nahezu aller Akteure wird sich rasch weiterentwickeln. Das Gesundheitssystem wird in allen Bereichen umgebaut und teilweise neu erfunden werden. Nanomedizin, digitale Transformation, Personalisierung und Prävention sind die Treiber der neuen Medizin.

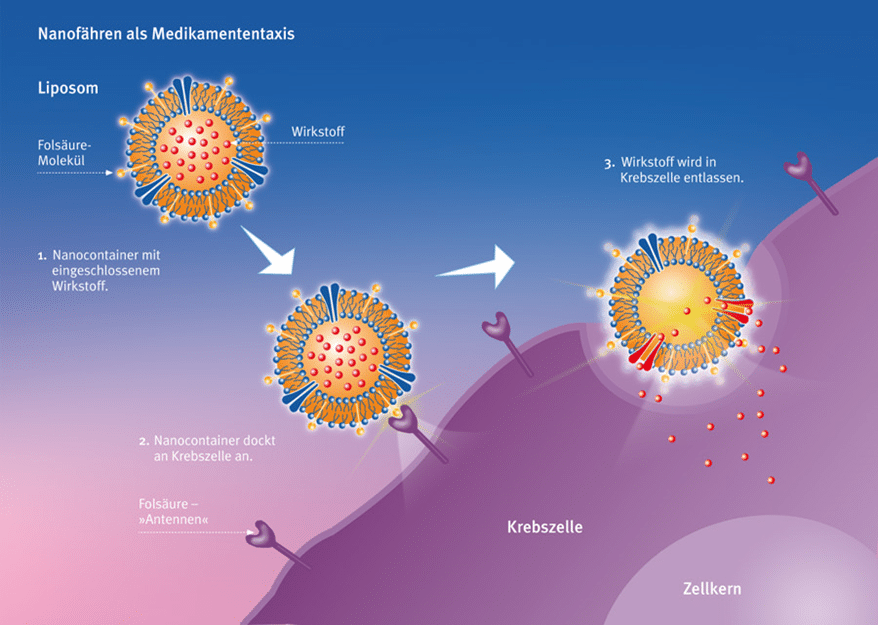

Nanomedizin ist grob vereinfacht die medizinische Anwendung von Technologien im Nanobereich. Klar ist, dass die Nanomedizin noch am Anfang steht, denn noch gibt es erst wenige zugelassene Therapien, die auf Nanomedizin basieren. So funktionieren bestimmte Impfstoffe gegen Grippe und Hepatitis mithilfe der Nanomedizin und es gibt gewisse zugelassene Medikamente gegen Krebs und Erkrankungen des Nervensystems. Klar ist aber auch, dass die Nanomedizin für die Zukunft unzählige, interessante Horizonte eröffnet und sehr vielfältig anwendbar ist. Denn viele Krankheitsprozesse im menschlichen Körper spielen sich im Nanobereich ab. Die Bausteine des Lebens – Proteine, Enzyme, DNA und andere wichtige Moleküle – sie alle haben Größenordnungen im Nanometerbereich.

Die Nanomedizin vermag die Grenzen der heutigen Therapieformen zu überschreiten. Ihre Risiken sind jedoch noch weitgehend unerforscht. Sie sind etwa 500-mal kleiner als der Durchmesser eines Erythrozyts und 80 000-mal kleiner als der eines menschlichen Haares – und dennoch sehr beeindruckend: Minimalinvasiv direkt in Tumorgewebe injizierte, etwa 20 Nanometer große Eisenoxidpartikel erzeugen nach Anlegen elektromagnetischer Wechselfelder Wärme, die Tumorzellen angreift oder zerstört.

Auch Nanofähren als Träger von wichtigen Medikamenten sind Teil des Nanomedizinprogramms.

Die Therapie unterscheidet zwischen Tumor- und Normalgewebe. „Jede Körperregion kann präzise erreicht werden, ohne das Normalgewebe zu beschädigen.“ Auch wiederholte Anwendungen seien aufgrund der geringen Nebenwirkungen möglich. Eine europäische Produktzulassung für das Glioblastom ist Anfang 2020 erfolgt. Aktuelle Forschungen richteten sich auf das Prostata-, das Mamma- und das Pankreaskarzinom sowie auf verschiedene Unterleibskrebsarten.

Die Digitalisierung im professionellen Gesundheitswesen soll im Wesentlichen die an den Behandlungsprozessen Beteiligten unterstützen und zu einer Verbesserung des Behandlungsergebnisses beitragen. Dabei entsteht jedoch regelmäßig ein Spannungsfeld hinsichtlich der ärztlichen Vorstellung, wie eine diesbezüglich gute IT-Lösung aussieht. Ein wesentlicher Faktor sind standardisierte Schnittstellen: Sowohl die Arzt-Arzt-Kommunikation (früher: Telefon und Fax, heute/künftig: E-Mail und Messenger) als auch die Arzt-Patient-Kommunikation (früher: persönliche Vorstellung, heute/künftig: Fernbehandlung) erfordern technisch kompatible Möglichkeiten für den Austausch von Informationen. Dafür ist aber auch der Zustand der zugrunde liegenden Patientendaten von entscheidender Bedeutung. Clinical Decision Support beispielsweise profitiert insbesondere davon, wenn ausreichend strukturiert und mit einheitlicher Terminologie dokumentiert wird, da die erforderliche Aufbereitung und Interpretation von freitextlichen Befunden zusätzlichen Aufwand und auch zusätzliches Unsicherheitspotenzial bedeuten.

Im weitesten Sinn bedeutet personalisierte Medizin die Berücksichtigung individueller Eigenschaften von Patient*innen in der Diagnose, Therapie, und auch in der Prävention. Damit steht der Mensch mit seinen spezifischen Merkmalen im Mittelpunkt der Personalisierten Medizin. Das ist die Vision, die hinter dem Begriff steht. Ein breiteres Verständnis von personalisierter Medizin geht über die Nutzbarmachung von großen Datenmengen hinaus. Diesem Verständnis zufolge soll es bei der Vorsorge, Diagnose und Therapie von Krankheiten stärker darum gehen, den Menschen als Ganzes zu sehen. Das heißt, insbesondere auch die psychische Gesundheit und das soziale Umfeld einer/s Patient*in zu berücksichtigen.

Obwohl die personalisierte Medizin noch am Anfang ihrer Entwicklung steht, wirft der Ansatz der Personalisierung schon heute eine Reihe von Fragen auf. Das betrifft zum Beispiel die technische Umsetzung und den Umgang mit gesammelten Daten. Wie können große Datenmengen verarbeitet und interpretiert werden und vor allem, wie kann der Schutz der Daten gewährleistet werden? Ebenso ist ungeklärt, wie sich die Kosten entwickeln werden und wer diese tragen soll. Darüber hinaus muss man sich der Frage stellen, wie sich mit der Umsetzung der personalisierten Medizin das Verhältnis zwischen Ärzt*innen und Patient*innen verändern wird.

Prävention ist im Gesundheitswesen ein Oberbegriff für zielgerichtete Maßnahmen und Aktivitäten, um Krankheiten oder gesundheitliche Schädigungen zu vermeiden, das Risiko der Erkrankung zu verringern oder ihr Auftreten zu verzögern. Präventive Maßnahmen lassen sich nach dem Zeitpunkt, zu dem sie eingesetzt werden, der primären, der sekundären oder der tertiären Prävention zuordnen.

Die primäre Prävention zielt darauf ab, die Entstehung von Krankheiten zu verhindern. Gerade „Volkskrankheiten“ wie Diabetes mellitus Typ 2 oder Herz-Kreislauf-Erkrankungen (z. B. Herzinfarkt), aber auch einige psychische Störungen (z. B. Depression) können in vielen Fällen durch eine gesundheitsbewusste Lebensweise – unterstützt von gesundheitsfördernden Lebensbedingungen – vermieden, verzögert oder in ihrem Verlauf günstig beeinflusst werden. Zu den begünstigenden Faktoren zählen u. a. eine gesunde Ernährung, sportliche Aktivitäten oder eine gute Stressbewältigung. Durch Impfungen, die auch zu Maßnahmen der primären Prävention zählen, lassen sich verschiedene schwerwiegende Infektionskrankheiten verhindern.

Die sekundäre Prävention ist auf die Früherkennung von Krankheiten gerichtet. Erkrankungen sollen zu einem möglichst frühen Zeitpunkt erkannt werden, um so eine frühzeitige Therapie einleiten zu können.

Die tertiäre Prävention hat das Ziel, Krankheitsfolgen zu mildern, einen Rückfall bei schon entstandenen Krankheiten zu vermeiden und die Verschlimmerung der Erkrankung zu verhindern. Die tertiäre Prävention ist weitgehend identisch mit Kuraufenthalten und medizinischen Rehabilitationsmaßnahmen.

Welche Entwicklungen können die Schüler*innen persönlich treffen? Gibt es schon Erfahrungen mit einigen dieser Entwicklungen? Wann werden sie realisiert werden können?

VI. Werkstoffe der Zukunft

Werkstoffe der Zukunft spielen eine viel größere Rolle als wir im Alltag sehen. Dabei geht es um die verbesserte Organisation von Konstruktion und Fertigungen, aber auch um neue Materialien:

Der Dreiklang „Werkstoff – Konstruktion – Fertigung“ ist besonders zu beachten; damit wird interdisziplinäres Arbeiten ausgebaut und die Lücke zwischen Materialentwicklung und fertigem Produkt schließen. Eine ausgeprägte interdisziplinäre Forschung zwischen Werkstoffentwicklung, Produktentwicklung und Fertigungstechnologie ist in Deutschland und Österreich zu wenig ausgebaut und muss in Form von Pilotprojekten an Hochschulen und Forschungseinrichtungen forciert werden. Die Entwicklung von Demonstratoren, die Einrichtung von Innovation-Labs sowie die vermehrte Durchführung von Validierungsprojekten sind wichtig.

Neue, innovative Werkstoffe werden von Unternehmen oft zögerlich eingesetzt, weil damit häufig ein hohes ökonomisches Risiko einhergeht sowie Normen und Standards verändert werden müssten. Außerdem erfordern sie häufig markante Umstellungen im eigenen Betrieb: Beispielsweise ändern sich der etablierte Produktionsprozess, die Verarbeitung der Produkte und die Arbeitsorganisation. Über Jahre aufgebaute Kompetenzen werden plötzlich hinfällig, neue müssen erlernt werden. Ein Beispiel dafür ist der Einsatz von innovativen Glasfaserleitungen für die Telekommunikation: Für die Unternehmen war es kurzfristig betrachtet günstiger, wie gewohnt klassische Kupferleitungen zu verlegen – neue Arbeitsabläufe, neue Geräte oder neue Kompetenzen bei Mitarbeitenden waren dafür nicht nötig. Heute liegt darin eine Ursache des schleppenden Netzausbaus in Deutschland (in Österreich ist es etwas besser). Daher erfordert es Mut von Unternehmen, innovative Werkstoffe schneller in die Umsetzung zu bringen. Was sind nun die neuen Werkstoffe?

Lithium: Das weiße Gold

Lithium wird in unserem Leben bald eine größere Rolle einnehmen. Bereits jetzt läuft ein Großteil der elektronischen Geräte mit Lithiumbatterien, egal ob iPhone oder Akkubohrer. Doch mit den Alltagsgeräten ist das Potenzial des Materials noch lange nicht ausgeschöpft. Leistungsstarke Batterien können etwa der E-Mobilität den entscheidenden Anstoß geben. Die Rechnung ist einfach: Je leistungsstärker der Akku, umso länger die Fahrt, umso attraktiver das E-Vehikel. Bis sich Elektro-Mobilität durchsetzen wird, ist der Hauptabnehmer von Lithium die Keramik-Branche: Der Stoff macht Keramik widerstandsfähiger und erhöht die Haltbarkeit und Festigkeit. Elektroautos gewinnen in Firmenflotten langsam an Bedeutung. Hohe Anschaffungskosten und eine schwach ausgebaute Infrastruktur schrecke Flottenmanager ab. Neue Mobilitätskonzepte wie das Carsharing liegen dagegen voll im Trend.

Keramikfasern: Der Hightech-Stoff für Extremfälle

Sie kann fein wie Spinnenseide sein, stabiler als Stahl oder extremer Hitzebelastung standhalten: Die Hochleistungsfaser ist ein kleines Wundermittel, das je nach Herstellverfahren und den Bestandteilen unterschiedliche Eigenschaften haben kann. Keramikfasern kommen bei der Wärmeisolation zum Einsatz oder können zu hitzeisolierenden Schutzanzügen verarbeitet werden.

Siliziumkarbid: Ein Super-Halbleiter der Kosten spart

Siliziumkarbid ist ein weiterer Stoff, der extrem hitzebeständig sein kann, allerdings ist er dabei auch noch enorm energieeffizient. Der Halbleiterwerkstoff hat dem „normalen“ Silizium deshalb einiges voraus: Es kann Temperaturen von 550 Grad überstehen, während Silizium nur 350 Grad aushält. Das macht Siliziumkarbid für verschiedene Branchen interessant. In den kommenden Jahren wird deshalb mit einer steigenden Nachfrage gerechnet, gerade aus dem Bereich der Leistungs- und Hochtemperaturelektronik, der Luft- und Raumfahrt sowie der Automobil-Branche.

Biokunststoffe: Die nachhaltige Alternative

Biokunststoffe sind vielleicht nichts Neues, sie erleben aber gerade einen regelrechten Aufschwung. Die Industrie setzt vermehrt auf nachwachsende Rohstoffe für die Herstellung ihrer Verpackungen. Dazu gehören biobasierte Polyamide und Polyurethane sowie Polymilchsäure. Durch die Nutzung von nachwachsenden Rohstoffen ist es möglich, mit fossilen Rohstoffen wie Erdöl künftig sorgfältiger umzugehen.

Carbon: Vom Rennsport in den Alltag

Nicht nur für Autoingenieure: Carbonfaserverstärkter Kunststoff (CFK) wird im Motorsport schon lange beim Bau von Rennwagen eingesetzt. Bald kann es allerdings auch abseits der Rennstrecke zu finden sein: Carbon ist bisher zwar noch sehr teuer, es bietet jedoch viele Vorteile. Das Material ist leichter als Aluminium und Magnesium. Außerdem ist es nur halb so schwer wie Stahl, trotzdem genauso fest. Gerade in der Luft- und Raumfahrtbranche kommen die Vorteile des Materials zum Tragen. Zurück geht die Entdeckung des Werkstoffs auf den General Electric -Gründer und Erfinder der Glühbirne Thomas Alva Edison. Noch 80 Jahre bevor NASA-Ingenieure Carbon für ihre Zwecke wiederentdeckten, extrahierte Edison im Jahr 1879 in seinem Labor im Menlo Park den vielfältigen Werkstoff. Dessen Einsatzgebiet erforscht GE bis heute und hat in den Laboren von Global Research etwa die metallenen Luftschaufeln in einem Düsenjet mit Carbon ersetzt, der nun leichter und damit effizienter unterwegs ist.

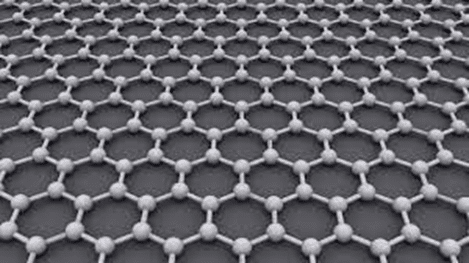

Graphen: Das gehypte Wundermaterial

Hauchdünn, biegsam und trotzdem stärker als Stahl: Auf diesen Stoff setzt die Technikbranche gerade ihre ganze Hoffnung, denn Graphen könnte sie revolutionieren. Es ist steif, dabei aber auch flexibel und 100- bis 300-mal zugfester als Stahl – bei gleichem Gewicht. Außerdem leitet es Strom und Wärme, aber keine Gase. Graphen entsteht durch die mechanische oder chemische Ablösung von Graphit, es kann allerdings auch künstlich zum Wachsen gebracht werden. Deutsche Wissenschaftler haben das Material außerdem zu Aerographit weiterentwickelt, dem momentan leichtesten Material der Welt. Der einzige Haken an Graphen ist die aufwändige Herstellung und der Preis: Ein briefmarkengroßes Stück kostet umgerechnet 4.000 Euro.

Titanaluminid macht das Fliegen leichter

Die Luftfahrt steckt in der Krise, zu hohe Treibstoffkosten machen der Branche zu schaffen. Um effizient zu bleiben, suchen die Triebwerkshersteller deshalb nach neuen Möglichkeiten, den Wirkungsgrad ihrer Antriebsaggregate zu erhöhen – und scheinen sie in Titanaluminid gefunden zu haben. Die intermetallische Verbindung aus Titan und Aluminium zeigt die gleiche Warmfestigkeit wie Nickel-Legierungen, hat allerdings eine viel geringere Dichte. Deshalb sind Bauteile aus Titanaluminid viel leichter und der Stoff ist gerade für die Luftfahrt- und Autobranche sehr interessant.

Heusler-Materialien: Ein superkleiner Datenspeicher

Schneller, kleiner, cleverer: Bei der Computertechnik wird künftig auf größere Leistungsfähigkeit in immer kleineren Bauteilen gesetzt. Vielleicht werden Heusler-Materialien der Industrie bald dabei helfen, diesen Traum zu verwirklichen. Heusler-Materialien bestehen aus mehreren metallischen Elementen in einer Gitterstruktur. Sie könnten ein neuer Werkstoff sein, um kleinere Datenspeicher mit höherer Speicherdichte zu bauen.

Mit der Analyse von neuen Werkstoffen sind wir an der Zukunft nahe dran. Sie passiert laufend und hat uns schon manche Annehmlichkeit im täglichen Leben beschert? Das kann ein Ausgangspunkt für eine interessante Diskussion sein.

VII. Weltraumtechnik und Besiedelung von anderen Planeten

Der Kreis unserer NAWI – Zukunftsbetrachtung schließt sich: Nicht nur ein bekannter Wetterredakteur spricht in seinem neuen Buch davon, dass die Erde nach einem Anstieg der Oberflächentemperatur von 4 bis 5 K (K Kelvin, die Einheit der absoluten Temperatur) durch lange Hitzeperioden praktisch unbewohnbar wird. Also muss man an „Aussiedelung“ denken. Im Angebot hat das Planetensystem den Mars (wenn dort Wasser zu finden ist) und neuerdings einige Jupitermonde. Als Lebensgrundlage müssen Wasser und (aus Wasser erzeugter) Sauerstoff vorhanden sein. Dann wäre mit umfassenden technischen Vorkehrungen ein bescheidenes Leben möglich. Aber wie dorthin gelangen: Immerhin geht es um große Entfernungen, die Menschen bis zum neuen „Wohnort“ zurücklegen müssen. Antriebe von Raumschiffen sind zu analysieren:

Der heutige Standard – Wasserstoff und Sauerstoff

Der „chemische“ Antrieb mit Wasser- und Sauerstoff ist heute weit entwickelt und kaum noch steigerbar. So beträgt die Energieausnutzung eines Treibstoffes heute zirka 98 %, d.h. man kann Raketentriebwerke nicht wesentlich effizienter bauen. Auch besteht wenig Hoffnung, noch leistungsfähigere Treibstoffe zu entwickeln. Noch leistungsfähigere Treibstoffe sind entweder giftig, instabil oder haben einen zu hohen Preis. Die Kombination Wasserstoff mit Sauerstoff erreicht heute Ausströmungsgeschwindigkeiten von 4500 m/s, das technisch nutzbare Maximum liegt bei 4600 m/s.

Die meisten unten vorgestellten alternativen Antriebe können funktionsbedingt oder aus sicherheitstechnischen Gründen erst in einer Erdumlaufbahn betrieben werden, sodass der Transport in eine niedere Umlaufbahn auch heute noch durch chemische Antriebe bewerkstelligt werden muss.

1. Der Ionenantrieb

Grundprinzip: Der Ionenantrieb ist eine Antriebsmethode für Raumfahrzeuge; ein Ionentriebwerk nutzt den Rückstoß eines erzeugten (neutralisierten) Ionenstrahls zur Fortbewegung. Je nach genutzter Energiequelle wird zwischen solarelektrischem (engl. Solar Electric Propulsion, SEP) und nuklearelektrischem Antrieb (engl. Nuclear Electric Propulsion, NEP) unterschieden.

Ionentriebwerke erzeugen zwar einen für einen Raketenstart direkt von der Erde zu geringen Schub, verbrauchen aber weniger Stützmasse als chemische Triebwerke. Deshalb sind sie als Sekundärtriebwerke für den energieeffizienten Dauerbetrieb geeignet, besonders für die langen Flugbahnen. Ein Stoff wird ionisiert. Ionisieren bedeutet das dem Stoff einige Elektronen entzogen werden. Dadurch wird der restliche Atomkern positiv geladen. Schon auf einer kurzen Strecke erreicht das Teilchen eine sehr hohe Geschwindigkeit, die weit höher liegt als die von chemischen Treibstoffen.

Aussichten: Bisherige Ionenantriebe besitzen gegenüber konventionellen chemischen Raketentriebwerken einen weit geringeren Schub, bei Sondenantrieben etwa vergleichbar mit der Gewichtskraft einer Postkarte (70 Millinewton), jedoch bei einer deutlich erhöhten Austrittsgeschwindigkeit des Gases (10 bis 130 km/s, Prototypen bis 210 km/s.

Ionenantriebe herkömmlicher Bauart funktionierten nur im Vakuum. Die durch übliche Luftbewegungen ausgeübte Kraft ist meist größer als der Schub. Im November 2018 stellten Wissenschaftler des MIT die Entwicklung eines in der Atmosphäre funktionsfähigen Ionenantriebs vor. Zum Transport größerer Massen eignen sich Ionentriebwerke daher nur, wenn sie über längere Zeit (Wochen, Monate oder Jahre) arbeiten können.

2. Nukleare Triebwerke

Grundprinzip: Der nukleare Pulsantrieb ist ein Vorschlag für den Antrieb von Raumschiffen, dem zufolge durch Atomexplosionen Schub erzeugt würde. Nukleare Triebwerke basieren auf einem Kernreaktor als Wärmequelle. Ein Kernreaktor erzeugt eine große Hitze, die dazu benutzt wird, Wasserstoff auf über 2000 Grad Celsius aufzuheizen. Neuere Konzepte, die die Trägheitsfusion verwenden, sind die Grundlage für die meisten Projekte nach Orion gewesen. Zur Durchführung eines nuklearen Triebwerkes muss ein Reaktor wesentlich kleiner als ein herkömmlicher Kernreaktor sein, gleichzeitig sind die Anforderungen an die Arbeitstemperatur sehr viel höher. Bedingt durch die geringe Molekülmasse des Wasserstoffs erreichen nukleare Triebwerke sehr hohe Ausström-Geschwindigkeiten. Bei dem schon realisierten Versuchstriebwerk NERVA (Nuclear Engine for Rocket Vehicle Application) beträgt der spezifische Impuls 8100 N *s / kg. Damals erreichte dieses Triebwerk einen Schub von 245 kN.

Aussichten: Ein nukleares Triebwerk liefert den mit Abstand größten Schub aller hier vorgestellten Triebwerke. Der Wasserstoff tritt mit sehr hoher Austrittsgeschwindigkeit durch die Raketendüse und sorgt damit für einen kraftvollen Vortrieb der Rakete.

Grundprinzip: Die NASA möchte ein Triebwerk entwickeln, das Wasserstoff auf 2700 Grad erhitzt. Die Wärmequelle ist dabei aber kein Reaktor, sondern die Sonne, die durch Spiegel und Linsen in einem Brennpunkt die hohe Hitze erzeugt. Das prinzipielle Problem dieses Reaktors ist die Isolierung des Wasserstoffes, der flüssig bei -253 Grad gelagert werden muss.

Aussichten: Aufgrund des Funktionsprinzips ist anzunehmen, dass mindestens der spezifische Impuls von nuklearen Triebwerken erreicht wird.

4. Magnetschienen Bahnen

Grundprinzip: Auf einer Schiene wird ein metallener Körper durch ein bewegtes Magnetfeld beschleunigt. Am Ende der Magnetschienen erreicht er eine hohe Geschwindigkeit. Das Prinzip ähnelt also dem einer Magnetschienenbahn.

Aussichten: Beim Aufprall auf die Luft in 8 Kilometer Höhe wird zudem die Nutzlast stark abgebremst und verformt. Angekommen in einem Orbit muss die Bahn stabilisiert werden, da der erdnächste Punkt durch den Abschuss auf der Erdoberfläche liegt.

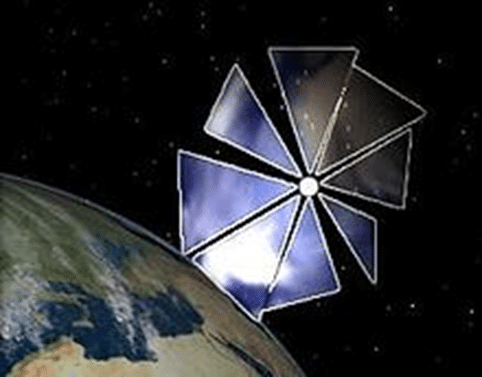

5. Sonnensegel

Grundprinzip: Auf jede Fläche übt die Sonne durch das Licht oder geladene Teilchen ein von der Sonne abgewandten Druck aus. Dieser beträgt in Erdnähe 9 N/km². Dieser Druck ist sehr gering. Die Segel nutzen die Photonen der Sonne für ihren Antrieb. Sie schweben zunächst nur langsam durchs All – die Geschwindigkeit beschleunigt sich aber mit der Zeit. Dadurch braucht ein Raumschiff mit Solarsegel keinen zusätzlichen Antrieb. Nur durch eine große Fläche und ein leichtes Material für das „Segel“ kann eine Nutzlast beschleunigt werden.

Aussichten: Ein Segel ist wegen der großen Masse nicht so einfach nach der Sonne auszurichten, weshalb der Start in einer Erdumlaufbahn Probleme aufwirft. Der große Vorteil eines Sonnensegels ist, dass es keinerlei Treibstoff benötigt. Solange sich die Sonde in der Nähe der Sonne bewegt, kann jedes Ziel erreicht werden, auch wenn es dauern kann.

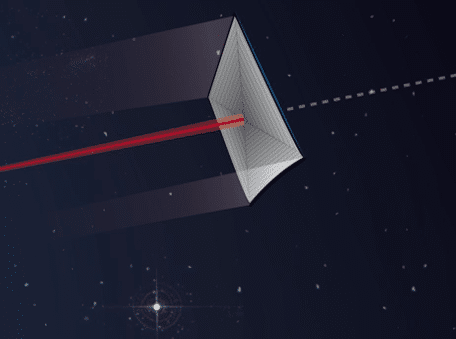

6. Laserantrieb

Grundprinzip: Analog dem Antrieb eines Sonnensegels über den Strahlungsdruck der Sonne würde ein Laser eine größere Fläche bestrahlen. Bei einer hohen Reflexion und einer temperaturbeständigen Legierung könnte auf diese Fläche ein Vielfaches der Sonnenenergie eingestrahlt werden, so dass ein Raumschiff erheblich schneller beschleunigt werden kann und die Masse für die Auffangfläche kleiner sein kann. Um die Erde würden in diesem Fall am besten mehrere leistungsstarke Laser kreisen. Die wären auf das zu beschleunigende Raumschiff ausgerichtet. Dabei übertragen die Photonen einen Impuls auf das Segel – und beschleunigen es.

Aussichten: Ein Vorteil der Technologie ist, dass das Antriebssystem nahe der Erde bleibt und nicht im Raumschiff steckt. Das spart Energie, weil deutlich weniger Masse beschleunigt werden muss. Der Nachteil ist, dass im Vergleich zum Schub der Sonne eine sehr hohe Strahlungsleistung nötig ist. (Bild: Der Spiegel, März 2016)

Fazit: Die meisten viel versprechenden Antriebe funktionieren nur im Orbit. Mit den leistungsfähigsten chemischen Antrieben kann man maximal 7 % Nutzlast in den Orbit befördern. Man startet nicht vom Erdboden aus, sondern in größerer Höhe um einen Teil der Höhe zum Orbit schon zurückzulegen und vor allem die Reibung in den unteren Luftschichten zu vermindern. Diesem Huckepack Prinzip sind aber Grenzen gesetzt. Das größte Flugzeug ist eine A-380, die ein Leergewicht von 291 t und ein maximales Startgewicht von 560 t hat. Da man auch Treibstoff für das Flugzeug zuladen muss kann dieses maximal 200 t Nutzlast transportieren.

Mit welcher Antriebstechnologie auch immer würde eine Reise zu anderen Planeten oder Monden mehrere Monate in Anspruch nehmen. Wie der menschliche Körper auf längere Reisephasen ohne Schwerkraft und hohen Dosen kosmischer Strahlung ausgesetzt, reagieren wurde, ist erst zum Teil erforscht.

Es braucht noch eine Menge Forschung und Praxistests, um über die konventionellen Antriebe, der Kombination von Wasserstoff und Sauerstoff hinauszukommen. Es ist daher technologisch keineswegs leicht, dauerhaft in den Weltraum zu anderen Himmelskörpern zu „pendeln“. Daher gibt es wohl, die Erde als lebenswerte Umgebung zu bewahren. Derzeit ist die Dämpfung des Klimawandels die wichtigste und auch einzige Option.

Abschlussdiskussion mit den Schülerinnen und Schülern und klare Schlussfolgerungen auf allen Ebenen ziehen. Welche drei Punkte sind für das Überleben der Menschheit besonders wichtig?

Literatur

- ARD – Alpha: Mit Geoengineering die Klimakrise stoppen: Science fiction oder Zukunftsoption? Autorin: Delia Friess, Heike Westram

- ARD – Alpha: Kernfusion – Die Energie der Sonne nutzen. Autorin: Franziska Konitzer

- Die Quantencomputer kommen, Ulf Hoffmann, Director Corporate Communications, Fraunhofer Institute for Open Communication Systems FOKUS, 10589 Berlin, Germany

- Johannsen et al. 2007, Jordan et al. 1999, Magforce AG 2008

- Bernd Leitenberger

https://www.bernd-leitenberger.de/zukuenftige_antriebe.shtml - Holger Dambeck, In 30 Minuten zum Mars, in: Der Spiegel, 3. März 2016.

- DerStandard, Diese 35 Erfindungen könnten uns die Zukunft eröffnen (1.11.2023)

https://www.derstandard.at/story/3000000191894/

Neueste Kommentare